Dies ist der zweite Teil der beiden Artikel über Superintelligenz. Du solltest zuerst Teil 1 lesen und dann diesen hier.

Weiter geht es mit der Übersetzung des zweiten Teils von WaitButWhy.com:

Wir stehen einem extrem schwierigen Problem gegenüber, von dem – ohne dass wir wissen, wieviel Zeit uns zu seiner Lösung bleibt – in einem ganz realen Sinne die gesamte Zukunft der Menschheit abhängt. – Nick Bostrom

Willkommen zum zweiten Teil von „Das soll realistisch sein? Aber warum sprechen nicht alle Leute darüber?“

Teil 1 begann ganz unschuldig mit Enger Künstlicher Intelligenz (EKI). Also KI, die sich auf eine engbegrenzte Aufgabe spezialisiert, wie die Berechnung der optimalen Fahrtroute oder das Schachspielen, und uns allgegenwärtig im Alltag begleitet.

Dann sind wir der Frage nachgegangen, warum es so schwer ist von EKI zu Allgemeiner Künstlicher Intelligenz (AKI) zu kommen. Also zu einer KI, die intellektuell in allen Bereichen mindestens genauso fähig ist wie ein Mensch. Überdies haben wir geklärt, warum vor dem Hintergrund des exponentiellen technischen Fortschritts, den wir schon erlebt haben, eine AKI nicht so weit in der Zukunft liegen muss, wie es zuerst erscheint.

Teil 1 endete damit, dass ich dich mit der Tatsache konfrontiert habe, dass Maschinen, sobald sie menschliche Intelligenz erreicht haben, Folgendes tun könnten:

Das lies uns staunend zurück: die schwerwiegende Idee, dass in unserer Lebenszeit noch Künstliche Superintelligenz entstehen könnte. Also KI, die viel klüger ist als jeder Mensch, in jeder Hinsicht. Und wir mussten uns überlegen, wie wir nun emotional dazu stehen.

Bevor wir tiefer einsteigen, möchte ich nochmal daran erinnern, was es für eine Maschine bedeuten würde, superintelligent zu sein.

Eine wichtige Unterscheidung ist die zwischen Geschwindigkeitssuperintelligenz und Qualitätssuperintelligenz.

Oftmals denken Leute, wenn sie sich einen super-schlauen Computer vorstellen, an etwas, das genauso intelligent wie ein Mensch ist, aber viel, viel schneller arbeitet. Sie stellen sich eine Maschine vor, die wie ein Mensch denkt, nur eine Million Mal schneller. Was bedeutet, dass die Maschine in fünf Minuten lösen kann, wofür ein Mensch ein Jahrzehnt benötigt.

Das klingt beeindruckend und KSI würde viel schneller denken als jeder Mensch. Der wahre Unterschied wäre aber die Qualität der Intelligenz.

Und das ist etwas komplett Verschiedenes.

Was uns Menschen so viel intelligenter macht als einen Schimpansen ist nicht der Geschwindigkeitsunterschied unseres Denkens – es sind die zusätzlichen kognitiven Module des menschlichen Gehirns, die im Unterschied zum Schimpansen komplexe linguistische Repräsentationen oder langfristiges Planen und abstraktes Denken ermöglichen.

Selbst wenn wir das Schimpansen-Gehirn um den Faktor 1.000 beschleunigen würden, könnte dieses immer noch nicht auf unserem Niveau arbeiten. Nicht in 10 Jahren wäre es in der Lage, mit speziellen Werkzeugen ein verzwicktes Modell zusammenzubauen, obwohl dies ein Mensch in wenigen Stunden fertigbringt.

Und es gibt viele Bereiche der menschlichen Kognition, in die ein Schimpanse niemals vordringen könnte, egal wie lange er sich damit beschäftigen würde. Aber ein Schimpanse scheitert nicht nur dabei, Dinge zu tun, die wir Menschen können. Sein Gehirn hat nicht einmal eine Ahnung, dass diese Welten existieren. Ein Schimpanse kann mit einem Menschen vertraut sein, oder mit einem Wolkenkratzer. Er wäre aber nie in der Lage, zu begreifen, dass der Wolkenkratzer von Menschen gebaut wurde. In seiner Vorstellung sind alle Dinge dieser Größenordnung ein Teil der Natur. Punkt. Und es ist ihm nicht nur nicht möglich, einen Wolkenkratzer selbst zu bauen, er kann sich nicht einmal vorstellen, dass irgendjemand einen Wolkenkratzer bauen kann.

Das liegt an dem kleinen Unterschied in der Qualität der Intelligenz.

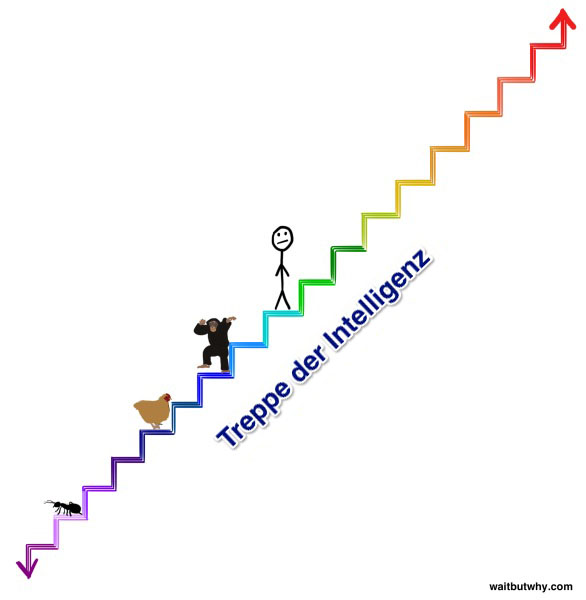

Wenn man sich das ganze Spektrum der Intelligenz, über das wir heute sprechen, vor Augen führt, dann ist der Unterschied in der Intelligenz zwischen einem Schimpansen und einem Menschen winzig.

Das trifft selbst dann zu, wenn man nur das Spektrum der Intelligenz aller Lebewesen betrachtet.

In einem früheren Artikel habe ich die Bandbreite der kognitiven Fähigkeiten mit Hilfe einer Treppe visualisiert:

Um dir klar zu machen, was für eine große Sache eine superintelligente Maschine wäre, stelle dir eine Maschine, zwei Stufen über dem Menschen, auf der dunkelgrünen Stufe vor.

Diese Maschine wäre nur ein bisschen superintelligent, aber die gesteigerten kognitiven Fähigkeiten wären genauso weitreichend wie zwischen Mensch und Schimpanse.

Ein Schimpanse ist nicht in der Lage, sich den Bau eines Hochhauses vorzustellen. Genauso könnten wir niemals die Dinge begreifen, die eine Maschine auf der dunkelgrünen Stufe vollbringen könnte. Selbst dann nicht, wenn die Maschine versuchen würde, es uns zu erklären. Und diese Dinge selbst zu tun, wäre genauso unmöglich. Und das nur zwei Stufen über uns.

Eine Maschine auf der zweithöchsten Stufe der obigen Darstellung stände zu uns so, wie wir zu einer Ameise stehen – sie könnte jahrelang versuchen, uns die allereinfachsten Dinge aus ihrer Gedankenwelt beizubringen und es bestünde doch keinerlei Hoffnung auf Erfolg.

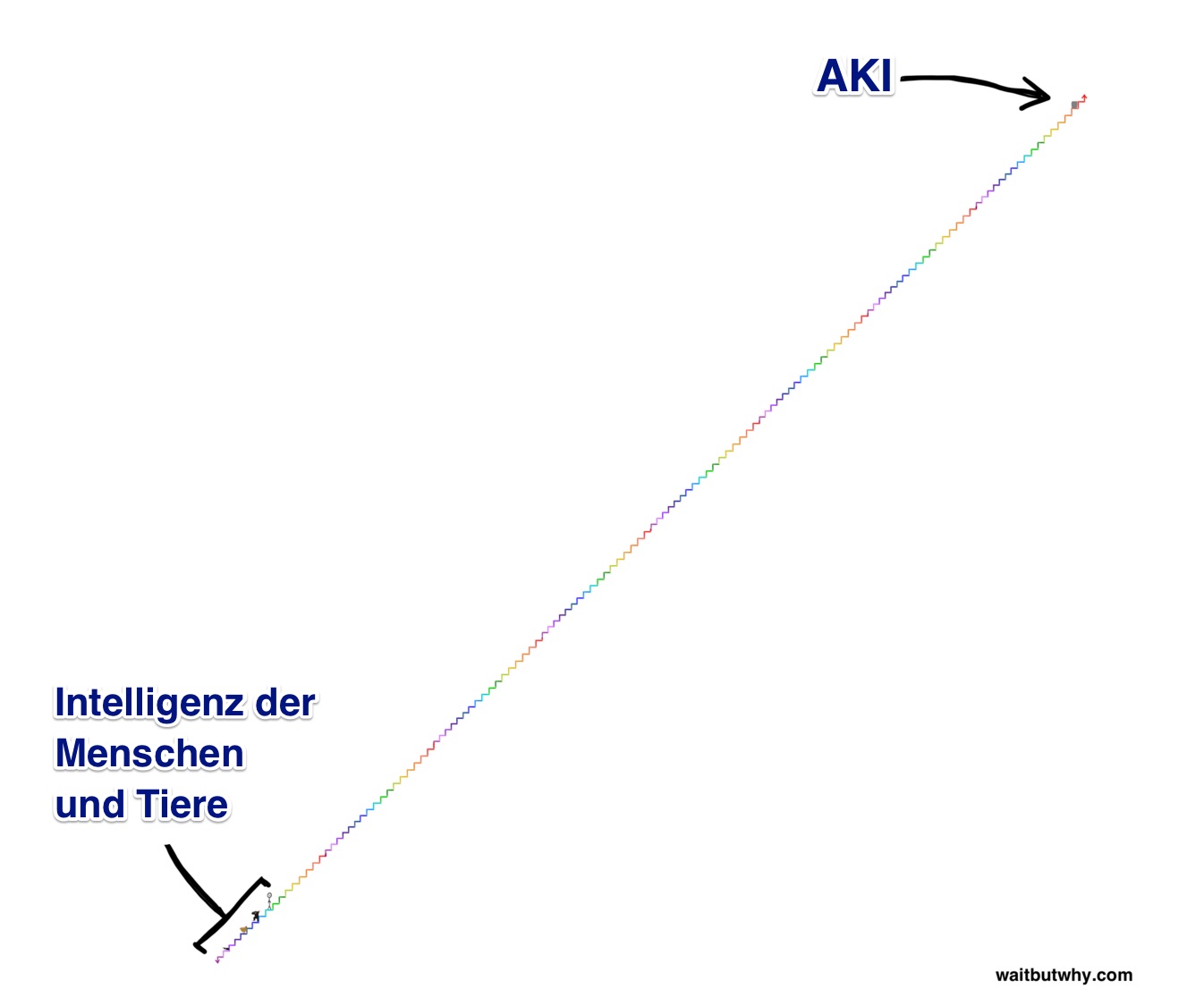

Aber die Art von Superintelligenz über die wir heute sprechen wollen, ist der obigen Treppendarstellung weit enteilt.

Vergegenwärtige dir eine Explosion der Intelligenz, in der eine Maschine mit jedem Intelligenzfortschritt noch schneller intelligenter wird, bis die Intelligenz der Maschine in die Höhe schnellt. In diesem Prozess könnte es anfangs Jahre dauern, bis der Schritt vom Schimpansen zum Menschen erreicht wird. Dann aber nur noch Stunden, um vom Niveau des Menschen auf die dunkelgrüne Stufe knapp über ihm zu gelangen. Und wenn sie dann zehn Stufen über unserem Niveau wäre, könnte sie vielleicht pro Sekunde schon vier weitere Stufen erklimmen.

Deshalb muss uns folgendes klar sein: Es ist durchaus möglich, dass wir kurz nach der ersten Berichterstattung über erfolgreiche menschenähnliche AKI schon in realer Koexistenz leben könnten mit etwas, das sich auf unserer Treppe etwa dort befindet (oder eine Million Mal höher):

Und da wir gerade schon gesehen haben, dass es ein hoffnungsloses Unterfangen ist, eine Maschine verstehen zu wollen, die nur zwei Stufen über unserer arbeitet, möchte ich hier ganz konkret und unmissverständlich festhalten, dass es überhaupt keinen Weg gibt, zu wissen, was eine AKI tun wird oder was die Konsequenzen für uns sein werden.

Jeder, der dem widerspricht, versteht nicht, was Superintelligenz bedeutet.

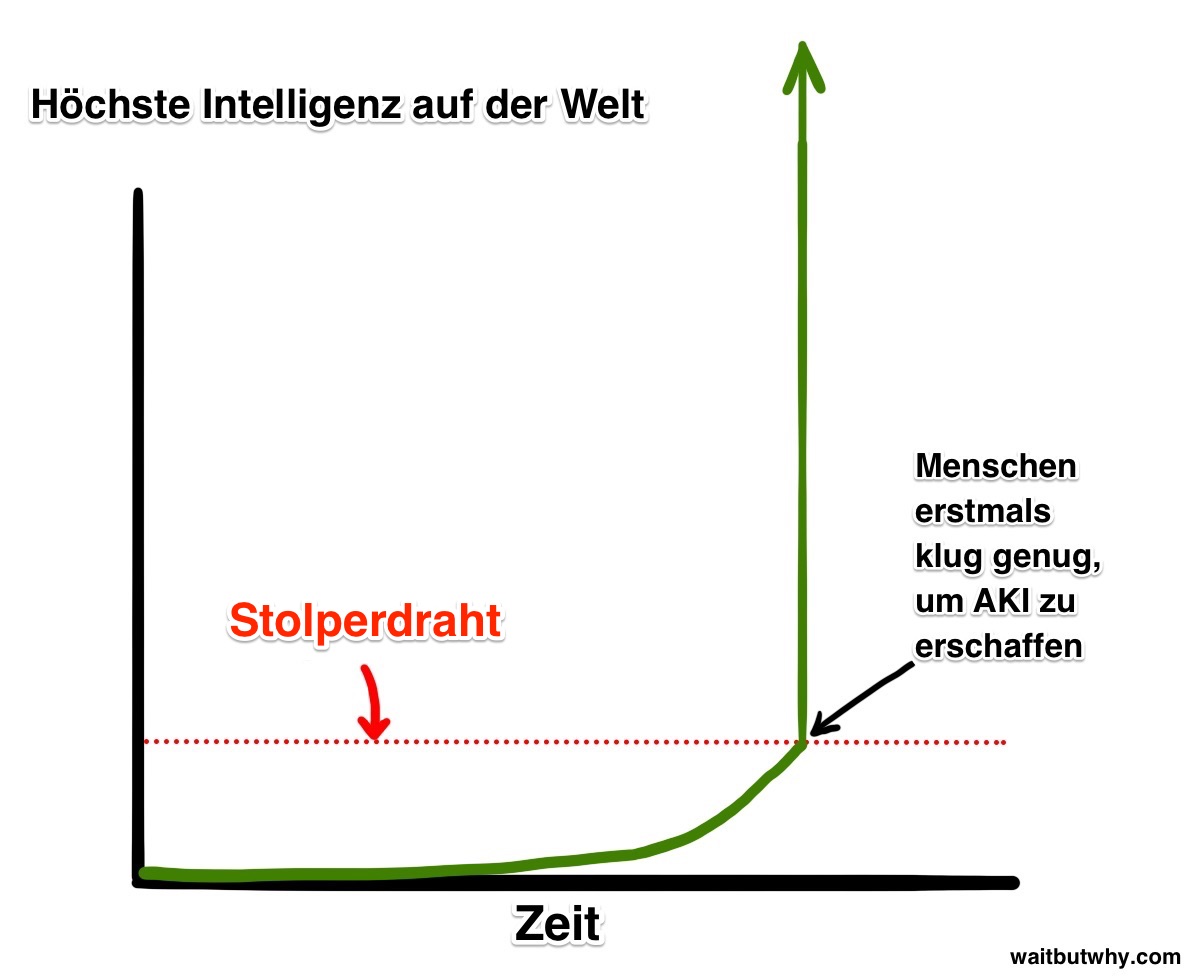

Die Evolution hat das biologische Gehirn im Laufe von hunderten Millionen von Jahren nach und nach verbessert. Und in diesem Sinne werden wir Menschen, wenn wir AKI erschaffen, der Evolution kräftig auf die Füße treten. Oder vielleicht ist es ein Teil der Evolution, dass die Intelligenz mühsam nach oben krabbelt bis sie das Niveau erreicht, um superintelligente Maschinen zu erschaffen. Und dieses Niveau gleicht einem Stolperdraht, der eine weltweite, grundlegende Veränderung auslöst und uns mit allen anderen Lebewesen in eine neue Zukunft katapultiert:

Und aus Gründen, die wir später besprechen werden, glaubt ein großer Teil der wissenschaftlichen Gemeinschaft, dass es keine Frage ist, ob wir diesen Stolperdraht erreichen, sondern nur eine Frage des Zeitpunktes.

Ziemlich verrückte Neuigkeiten.

Also, wie stehen wir nun dazu?

Nun, niemand auf dieser Erde, und ich schon gar nicht, kann dir sagen, was passieren wird, wenn wir diesen Stolperdraht auslösen.

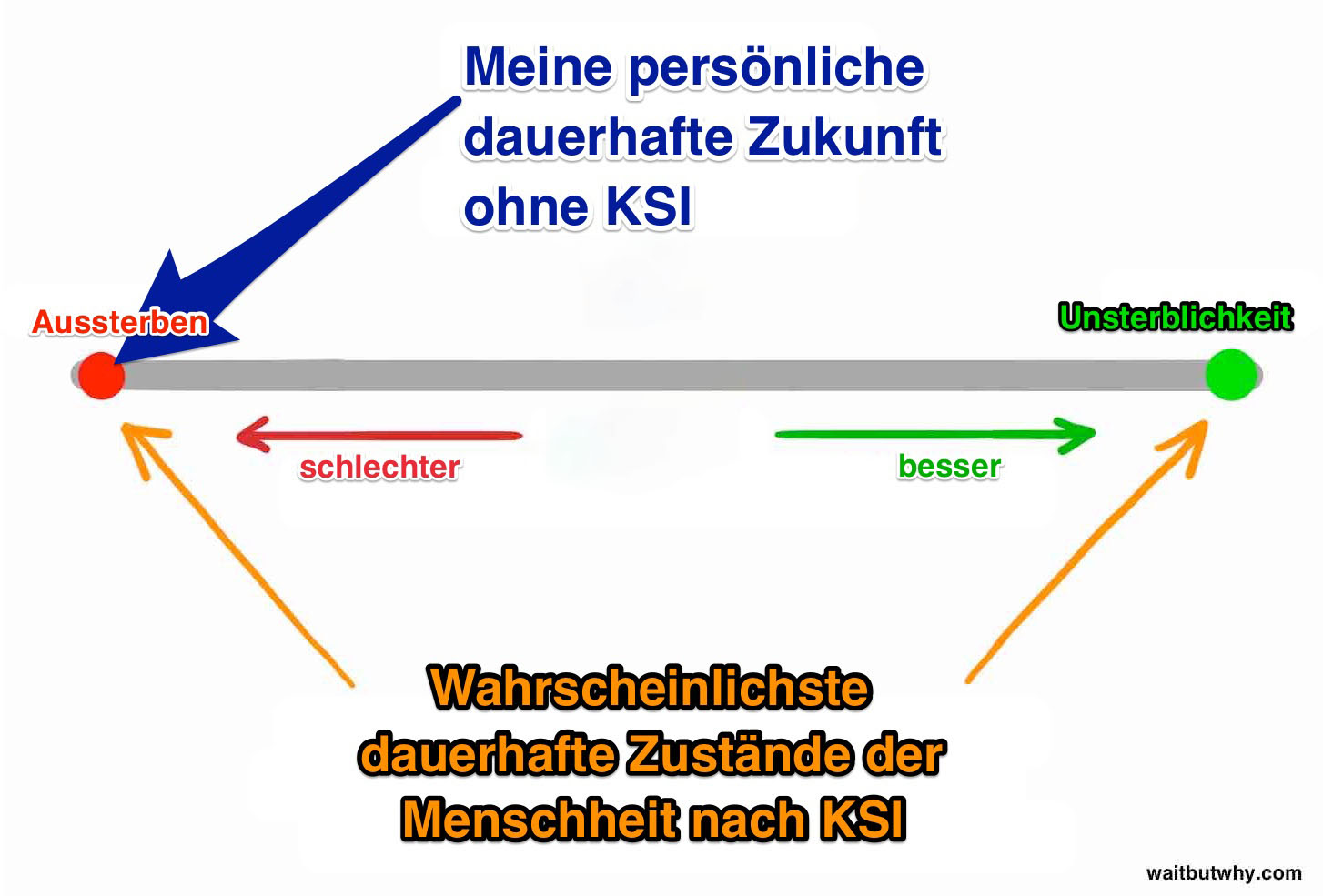

Aber der Philosoph der Universität Oxford und führende Vordenker der KI Nick Bostrom glaubt, dass es möglich ist, alle Szenarien in zwei weitgefasste Kategorien zu packen:

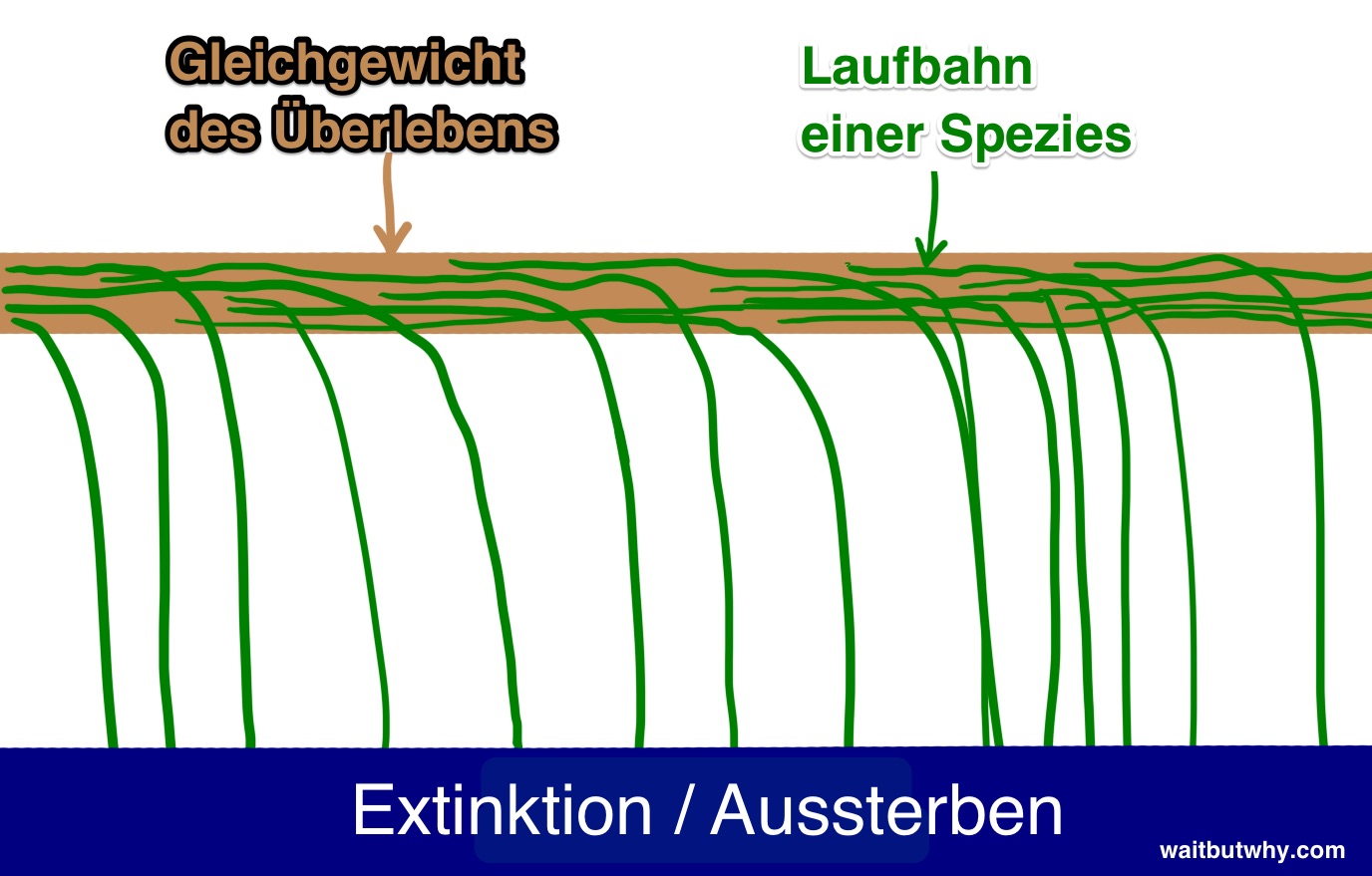

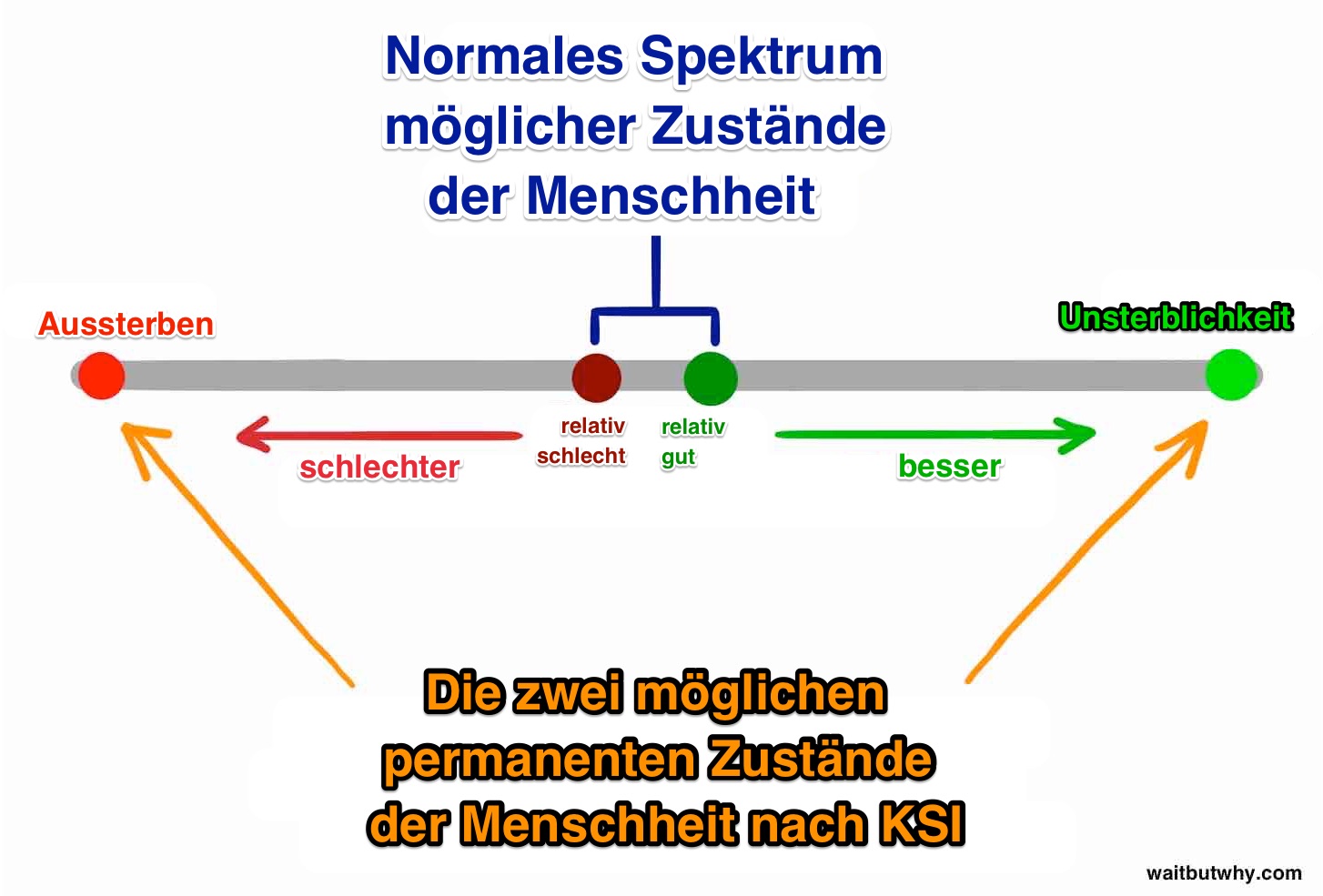

Erstens, wenn wir zurückblicken, dann sehen wir, dass das Leben folgendermaßen funktioniert: Spezies entstehen, existieren für eine Weile und nach einiger Zeit fallen sie vom Schwebebalken der Existenz und stürzen in die Extinktion, sterben also aus.

„Jede Spezies stirbt früher oder später aus“ war als Regel fast genauso zuverlässig während gesamten Geschichte wie „Alle Menschen sterben früher oder später“.

Bis jetzt sind 99.9% aller Spezies in die Extinktion gestürzt. Und es scheint ziemlich offensichtlich, dass es nur eine Frage der Zeit ist, bis eine Spezies, die den Balken immer länger entlang schwankt, von irgendeiner anderen Spezies, einer Laune der Natur oder einem Asteroiden heruntergestoßen wird.

Bostrom nennt die Extinktion einen Attraktor-Zustand – ein Ort, dem alle Spezies entgegentaumeln und von dem niemand je zurückgekehrt ist.

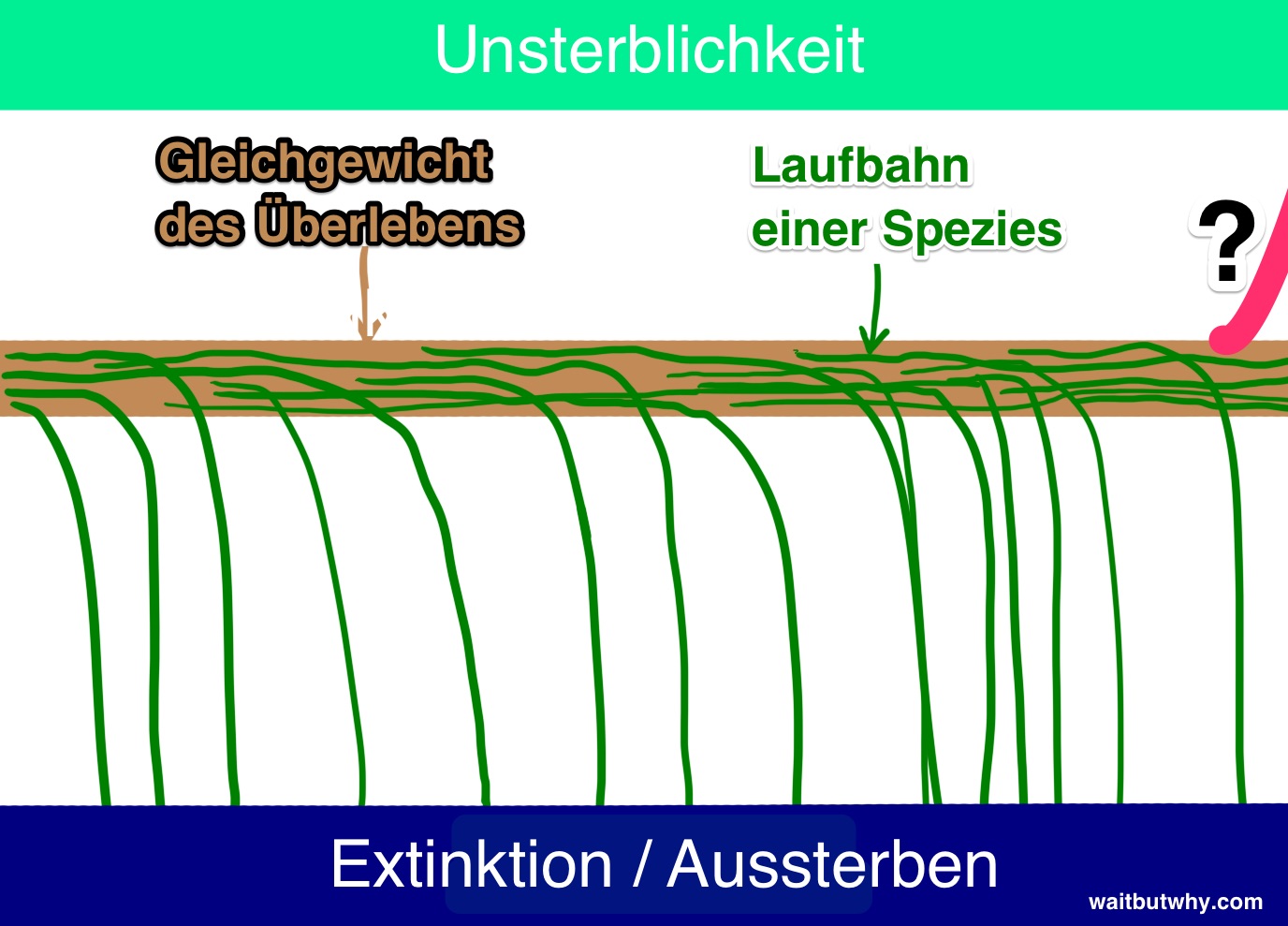

Und obwohl die meisten Wissenschaftler, mit denen ich gesprochen habe, die Perspektive des Aussterbens durch AKI anerkennen, glauben zahlreiche Wissenschaftler, dass die Möglichkeiten von AKI, wenn sie wohlwollend genutzt werden, uns als Spezies und einzelne Menschen in einen zweiten Attraktor-Zustand bringen könnten – nämlich die Unsterblichkeit der Spezies. Bostrom glaubt, dass die Unsterblichkeit einer Spezies genauso ein Attraktor- Zustand ist wie die Extinktion der Spezies.

Das heißt, wenn wir ihn erreichen, werden wir dem Aussterben für immer entkommen sein – wir werden die Sterblichkeit besiegt und den Zufall überwunden haben.

Obwohl also alle Spezies bis jetzt von dem Schwebebalken gefallen und in die Extinktion gestürzt sind, glaubt Bostrom, dass es eine zweite Seite des Balkens gibt. Nur auf der Erde war bisher noch niemand intelligent genug, um es zu schaffen, auf der anderen Seite herunterzufallen.

Wenn Bostrom und andere recht haben, und das deckt sich auch mit allem, was ich gelesen habe, dann scheint es so zu sein, dass wir zwei ziemlich schockierende Fakten verdauen müssen:

- Die Ankunft von AKI wird zum ersten Mal einer Spezies die Möglichkeit eröffnen, in Richtung Unsterblichkeit vom Balken zu stürzen.

- Die Ankunft von AKI wird so ein unvorstellbar großer Einschlag werden, dass die Menschheit mit hoher Wahrscheinlichkeit vom Balken fallen wird – in die eine Richtung oder die andere.

Es kann gut sein, dass mit dem Auslösen des Stolperdrahts die Beziehung der Menschheit zum Schwebebalken der Existenz endet und eine neue Welt entsteht – mit Menschen oder ohne Menschen.

Es macht den Eindruck, als sollte sich jeder Mensch im Augenblick nur eine Frage stellen: Wann werden wir den Stolperdraht auslösen und auf welcher Seite werden wir dann landen?

Niemand auf der Erde kennt auch nur die Antwort auf einen der beiden Teile dieser Frage. Jedoch haben viele der klügsten Menschen schon Jahrzehnte investiert, um darüber nachzudenken.

Der restliche Artikel wird dem nachgehen, was dabei herausgekommen ist.

—–

Sprich: Wie lange wird es dauern, bis die erste Maschine Superintelligenz erreicht?

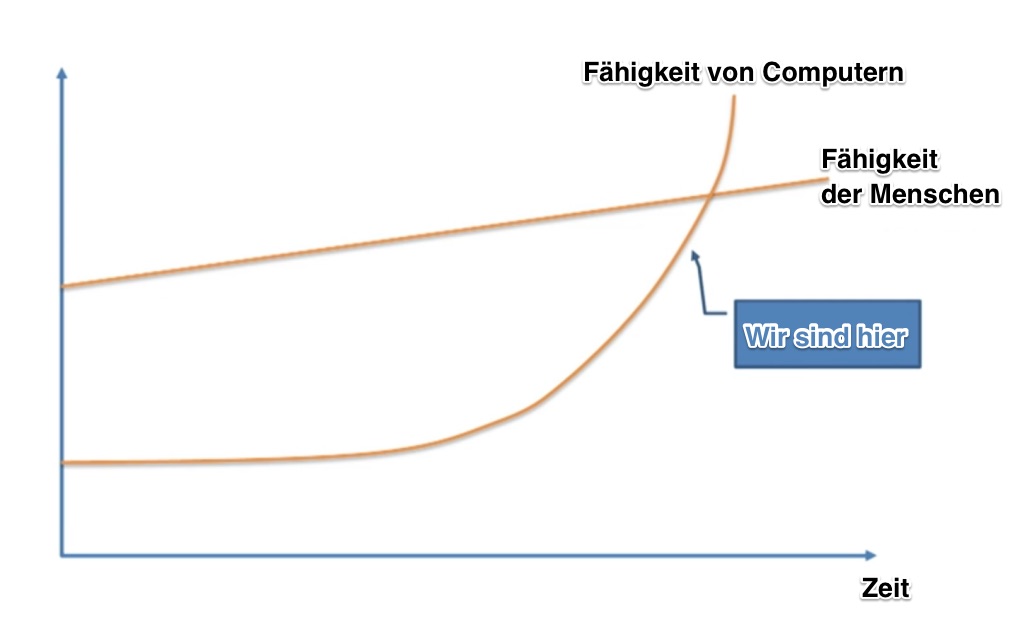

Wenig überraschend gehen die Meinungen dazu weit auseinander. Und die Debatte wird von den Wissenschaftlern und Vordenkern hitzig geführt. Viele, wie Professor Vernor Vinge, der Wissenschaftler Ben Goertzel, der Mitgründer von Sun Microsystems Bill Joy, oder vielleicht als Prominentester, der Erfinder und Zukunftsforscher Ray Kurzweil, stimmen mit dem Experten für Maschinenlernen Jeremy Howard überein, der in seinem TED-Talk folgendes vorschlägt:

Diese Leute glauben, dass dies bald passieren wird – das exponentielle Wachstum ist am Werk, und Maschinenlernen wird innerhalb der nächsten Jahrzehnte an uns vorbeischießen, obwohl es sich im Moment nur langsam an uns heranschleicht.

Andere, wie der Mitgründer von Microsoft Paul Allen, der Forscher und Psychologe Gary Marcus, der Informatiker an der NYU Ernest Davis und der Technologie-Unternehmer Mitch Kapor glauben, dass Vordenker wie Kurzweil das Ausmaß der Herausforderungen gewaltig unterschätzen und glauben stattdessen, dass wir uns in Wirklichkeit nicht so knapp vor dem Stolperdraht befinden.

Die Fraktion um Kurzweil würde dem entgegnen, dass ausschließlich das Wachstum in seiner exponentiellen Art unterschätzt wird. Und sie würden die Zweifler mit denen vergleichen, die beim Anblick des langsam keimenden Samens des Internets im Jahr 1985 die Meinung vertraten, dass daraus unter keinen Umständen in der nahen Zukunft irgendetwas Wirkungsvolles entstehen würde.

Die Zweifler könnten daraufhin erwidern, dass das Ausmaß an Fortschritt, das nötig ist, um die Intelligenz zu steigern, ebenfalls exponentiell mit jedem Schritt wächst. Wodurch die exponentielle Natur des technischen Fortschrittes nivelliert wird.

Und so weiter.

Ein drittes Lager, dem Nick Bostrom angehört, glaubt, dass sich keine der beiden vorherigen Fraktionen auch nur im Geringsten bezüglich des weiteren zeitlichen Ablaufes sicher sein kann. Er erkennt an, dass es A) sowohl in der nahen Zukunft schon so weit sein könnte und dass es B) keine Garantie dafür gibt; es ist auch möglich, dass es noch viel länger dauert.

Und wieder andere, wie der Philosoph Hubert Dreyfus, glauben, dass alle drei der obigen Gruppen naiv sind, zu glauben, dass es so etwas wie einen Stolperdraht überhaupt gäbe. Sie vertreten die Überzeugung, dass es wahrscheinlicher ist, dass AKI niemals Realität werden wird.

Also was ergibt sich, wenn wir all diese Meinungen zusammenbringen?

Im Jahr 2013 haben Vincent C. Müller und Nick Bostrom auf einer Reihe von Konferenzen eine Umfrage unter hunderten KI-Experten durchgeführt. Sie stellten darin die folgende Frage: „Nehmen Sie für diese Frage an, dass die wissenschaftliche Aktivität des Menschen ohne bedeutende negative Störung weitergeht. In welchem Jahr liegt nach Ihrer Einschätzung die Wahrscheinlichkeit für existierende MMI4 bei (10% / 50% / 90%)?“

Es wurde also nach einem optimistischen Jahr gefragt, in dem die Wahrscheinlichkeit für existierende AKI bei 10% liegt, einer realistischen Schätzung, bei dem die Wahrscheinlichkeit bei 50% liegt und einer sicheren Schätzung, bei der man schon mit 90% Wahrscheinlichkeit sagen kann, dass es AKI gibt.

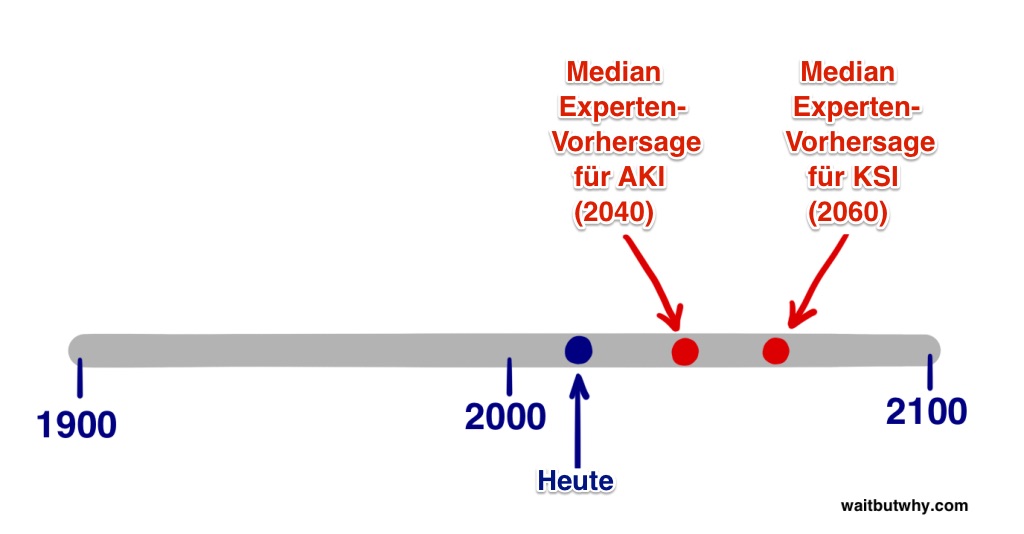

Zusammengefasst in einem Datensatz erhält man das folgende Ergebnis:

Der Median des optimistischen Jahres (10% Wahrscheinlichkeit): 2022

Der Median des realistischen Jahres (50% Wahrscheinlichkeit): 2040

Der Median des pessimistischen Jahres (90% Wahrscheinlichkeit): 2075

Der Median-Teilnehmer der Umfrage denkt also, dass wir in 25 Jahren eher AKI haben als nicht.

Die 90%-Median-Antwort von 2075 bedeutet, dass du als heutiger Teenager in deiner Lebenszeit fast mit Sicherheit noch AKI erleben wirst. Und diese Meinung hat nicht nur der Median-Teilnehmer, sondern auch die Hälfte der KI-Experten aus der Umfrage.

Eine andere Studie, die von dem Autoren James Barrat während der jährlichen AGI- Konferenz von Ben Goertzel durchgeführt wurde, interessierte sich nicht für Wahrscheinlichkeiten und fragte direkt, wann AKI erreicht sein würde: bis 2030, bis 2050, bis 2100, nach 2100 oder nie.

Die Ergebnisse:

Bis 2030: 42% der Befragten

Bis 2050: 25%

Bis 2100: 20%

Nach 2100: 10%

Nie: 2%

Also keine großen Unterschiede zu den Ergebnissen von Müller und Bostrom.

In der Umfrage von Barrat glauben über zwei Drittel der Teilnehmer, dass AKI bis 2050 erreicht werden wird. Und etwas weniger als die Hälfte sagen voraus, dass AKI in den nächsten 15 Jahren erreicht wird.

Bemerkenswert ist auch, dass nur etwa 2% denken, dass AKI nicht Teil unserer Zukunft sein wird.

Aber AKI ist nicht der Stolperdraht. Das ist erst KSI.

Wann glauben also die Experten, dass wir KSI erreichen?

Müller und Bostrom fragten die Experten auch, für wie Wahrscheinlich sie es halten, dass wir KSI erreichen

A) spätestens zwei Jahre nach erreichen von AKI (was einer nahezu unmittelbaren Intelligenz-Explosion gleichkäme) und B) innerhalb von 30 Jahren.

Die Ergebnisse: Die Median-Antwort ergab für einen schnellen AKI-KSI-Übergang innerhalb von zwei Jahren nur eine 10-prozentige Wahrscheinlichkeit. Ein langsamerer Übergang von maximal 30 Jahren aber eine Wahrscheinlichkeit von 75%.

Aus den obigen Daten können wir nicht ablesen, welche Übergangsdauer vom Median- Teilnehmer mit 50% Wahrscheinlichkeit angegeben worden wäre. Als grobe Schätzung schlage ich basierend auf den obigen Ergebnissen 20 Jahre vor.

Die Median-Meinung – also genau aus dem Zentrum der KI-Experten der Welt – glaubt, dass die realistischste Schätzung für das Erreichen des KSI-Stolperdrahts bei [2040 bis AKI + 20 Jahr nach meiner Schätzung] bei 2060 liegt.

Natürlich sind alle der obigen statistischen Ergebnisse spekulativ und sie repräsentieren nur eine moderate Meinung aus der KI-Experten-Gemeinde.

Aber sie zeigen uns, dass ein großer Teil der Leute, die am meisten über dieses Thema wissen, 2060 für eine vernünftige Schätzung für das Erreichen von möglicherweise weltverändernder KSI halten.

Das liegt nur 45 Jahre in der Zukunft.

Okay, jetzt also zum zweiten Teil der obigen Frage: Wann werden wir den Stolperdraht auslösen und auf welcher Seite werden wir dann landen?

Superintelligenz wird gewaltige Macht mit sich bringen – die entscheidende Frage für uns lautet:

Wer oder was wird diese Macht besitzen, und was wird dessen Motivation sein?

Die Antwort darauf wird bestimmen, ob KSI eine unbeschreiblich positive Entwicklung, eine unermesslich schreckliche Entwicklung oder etwas zwischen diesen Extremen sein wird.

Natürlich werden unter den Experten die verschiedensten Meinungen vertreten und es wird hitzig über diese Frage debattiert. In der Umfrage von Müller und Bostrom wurden die Teilnehmer gefragt, den verschiedenen vorstellbaren Auswirkungen von AKI auf die Menschheit eine Wahrscheinlichkeit zuzuordnen. Im Mittel ergaben die Antworten eine Wahrscheinlichkeit von 52% dafür, dass das Ergebnis entweder gut oder extrem gut sein wird und eine Wahrscheinlichkeit von 31% dafür, dass das Ergebnis entweder schlecht oder extrem schleicht sein wird. Die mittlere Wahrscheinlichkeit für ein relativ neutrales Ergebnis lag nur bei 17%.

Anders ausgedrückt, die Menschen, die sich mit diesem Thema am besten auskennen, sind sich ziemlich sicher, dass AKI große Auswirkungen mit sich bringen wird.

Und ich möchte nochmal darauf hinweisen, dass diese Zahlen über die Ankunft von AKI sprechen – wenn die Frage auf KSI abzielen würde, dann wäre der Anteil der neutralen Erwartungen nach meiner Vorstellung noch geringer.

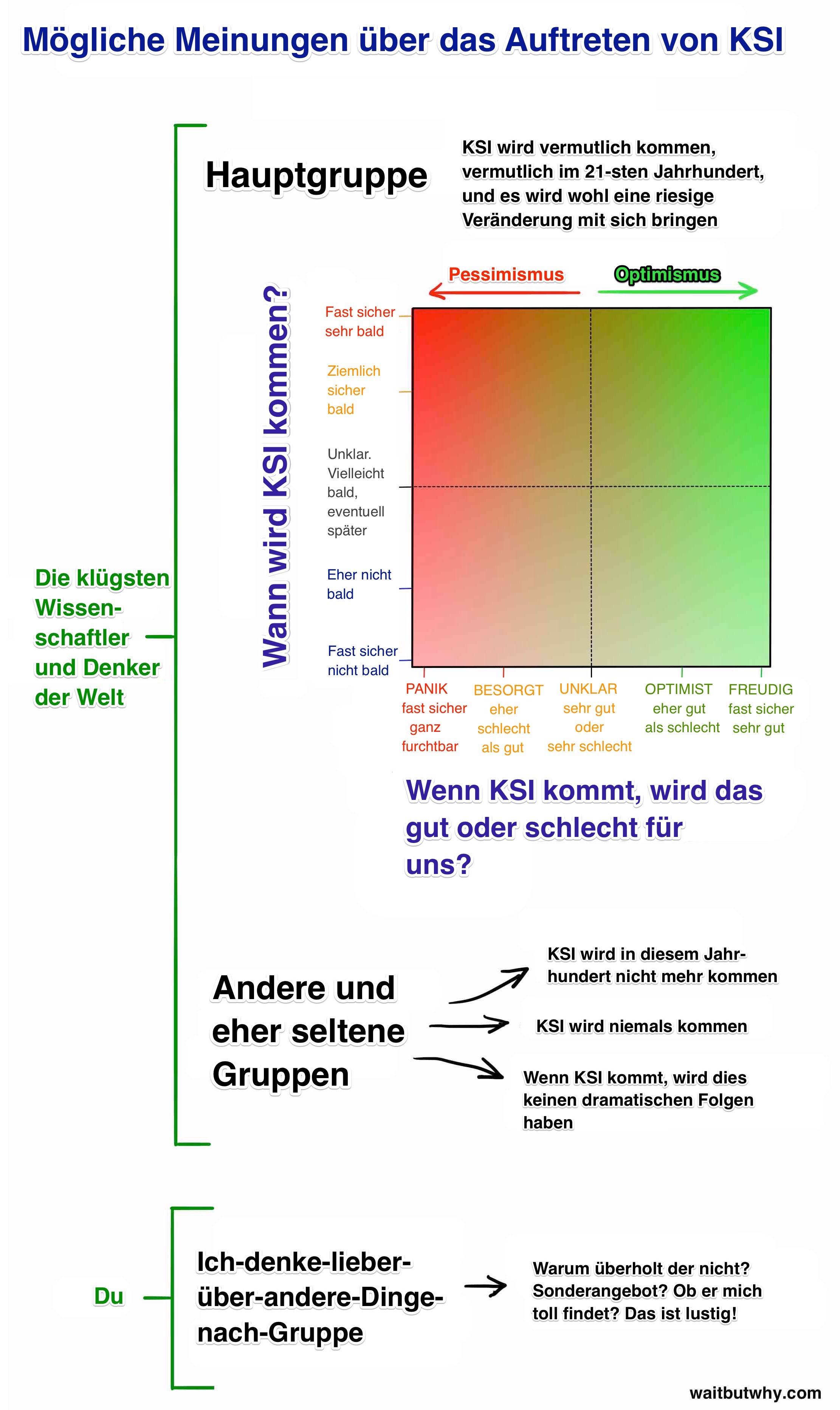

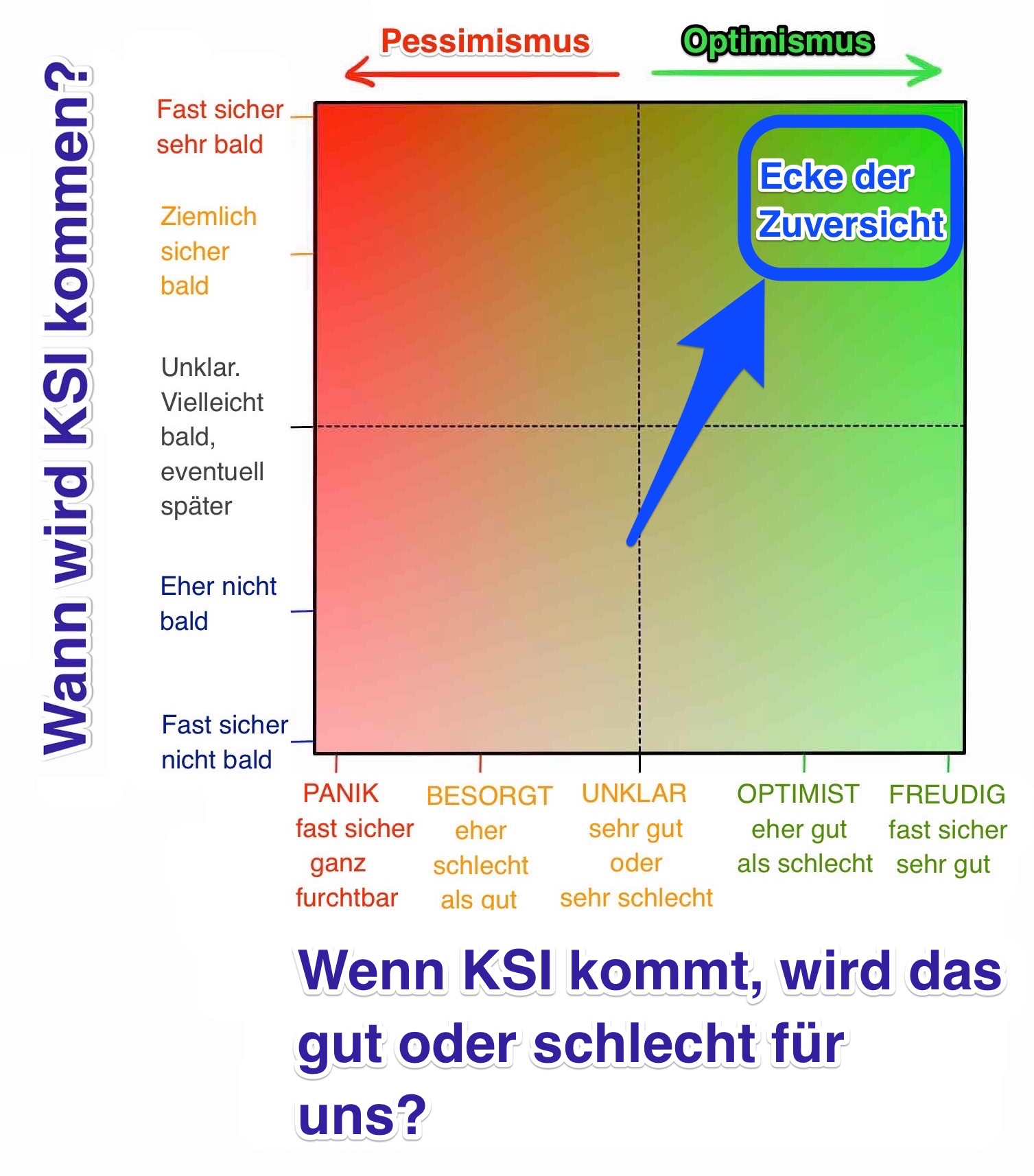

Bevor wir uns tiefer mit dem Gutes-Ergebnis-Schlechtes-Ergebnis-Teil der Frage beschäftigen, möchte ich eine Matrix entwerfen, die auf der einen Achse „Wird es gut oder schlecht werden?“ abbildet und auf der anderen Achse die Frage „Wann wird es passieren?“ darstellt. Damit lassen sich dann die Ansichten der meisten relevanten Experten sehr gut verorten:

Wir werden gleich noch genauer auf das Haupt-Lager eingehen, aber vorher: Wie geht es dir bis jetzt damit?

Ich kann dir sagen, was mit dir los ist, weil es mir, bevor ich mich mit dem Thema beschäftigt habe, genauso ging.

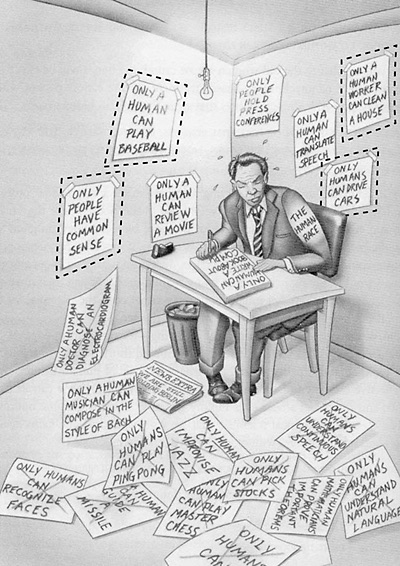

Einige Gründe, warum die meisten Leute sich nicht wirklich mit diesem Thema auseinandersetzen:

- Wie schon in Teil 1 erklärt, haben Filme für viel Verwirrung gesorgt, weil unrealistische KI-Szenarien dargestellt werden, die den Eindruck aufkommen lassen, das KI als Ganzes kein ernstzunehmendes Thema ist. James Barrat vergleicht diese Situation mit unserer Reaktion auf eine Warnung des Gesundheitsamtes vor Vampiren.

- Wegen der Kognitive Verzerrung genannten menschlichen Neigung fällt es uns schwer etwas für real zu halten, wenn wir keine Beweise dafür finden.

Sicher haben im Jahr 1988 die Informatiker darüber gesprochen, wie wichtig das Internet wahrscheinlich werden würde. Aber die normalen Leute haben wohl erst realisiert, wie grundlegend das Internet wirklich ihr Leben verändern würde als die Veränderungen tatsächlich eintraten.

Das lag zum Teil an der geringeren Leistungsfähigkeit der Computer im Jahr 1988. Die Leute sahen sich ihren Computer an und dachten: „Wirklich? Dieses Teil soll mein Leben auf den Kopf stellen?“

Ihre Vorstellungskraft war begrenzt durch ihre eigene Erfahrung mit Computern, wodurch sie es sehr schwer hatten, sich vorzustellen, was aus Computern werden könnte.

Das gleiche passiert nun im Bereich der KI. Wir hören, dass sie eine große Bedeutung haben wird. Weil es aber noch nicht passiert ist und aufgrund der relativ geringen Leistungsfähigkeit der aktuellen KI, haben wir große Probleme wirklich zu glauben, dass dadurch unser Leben dramatisch verändert werden könnte.

Und gegen diese Verzerrung versuchen die Experten verzweifelt unsere Aufmerksamkeit zu erregen und uns aus unserer alltäglichen Selbstvergessenheit zu reißen. - Selbst wenn wir es glauben würden – wie oft hast du heute darüber nachgedacht, dass du den größten Teil der Zukunft nicht existieren wirst? Nicht oft, richtig? Obwohl dies ein viel intensiverer Gedanke ist als alles andere, was du heute machst? Das liegt an unserem Gehirn, das sich auf die kleinen, alltäglichen Dinge konzentriert, ganz egal wie verrückt eine uns betreffende langfristige Situation sein mag. Wir sind einfach so verdrahtet.

Eines der Ziele dieser beiden Artikel ist, dich aus dem „Ich denke lieber über andere Dinge nach“-Lager herauszulocken und dich ins Expertenlager zu führen.

Und das auch dann, wenn du im Moment erst auf der Schnittstelle der beiden gepunkteten Linien stehst – in dem Rechteck über völliger Ungewissheit.

Während meiner Recherche sind mir dutzende verschiedene Meinungen zu diesem Thema begegnet. Mit fiel aber rasch auf, dass die Meinung der meisten Leute irgendwo in das von mir sogenannte Hauptlager fällt.

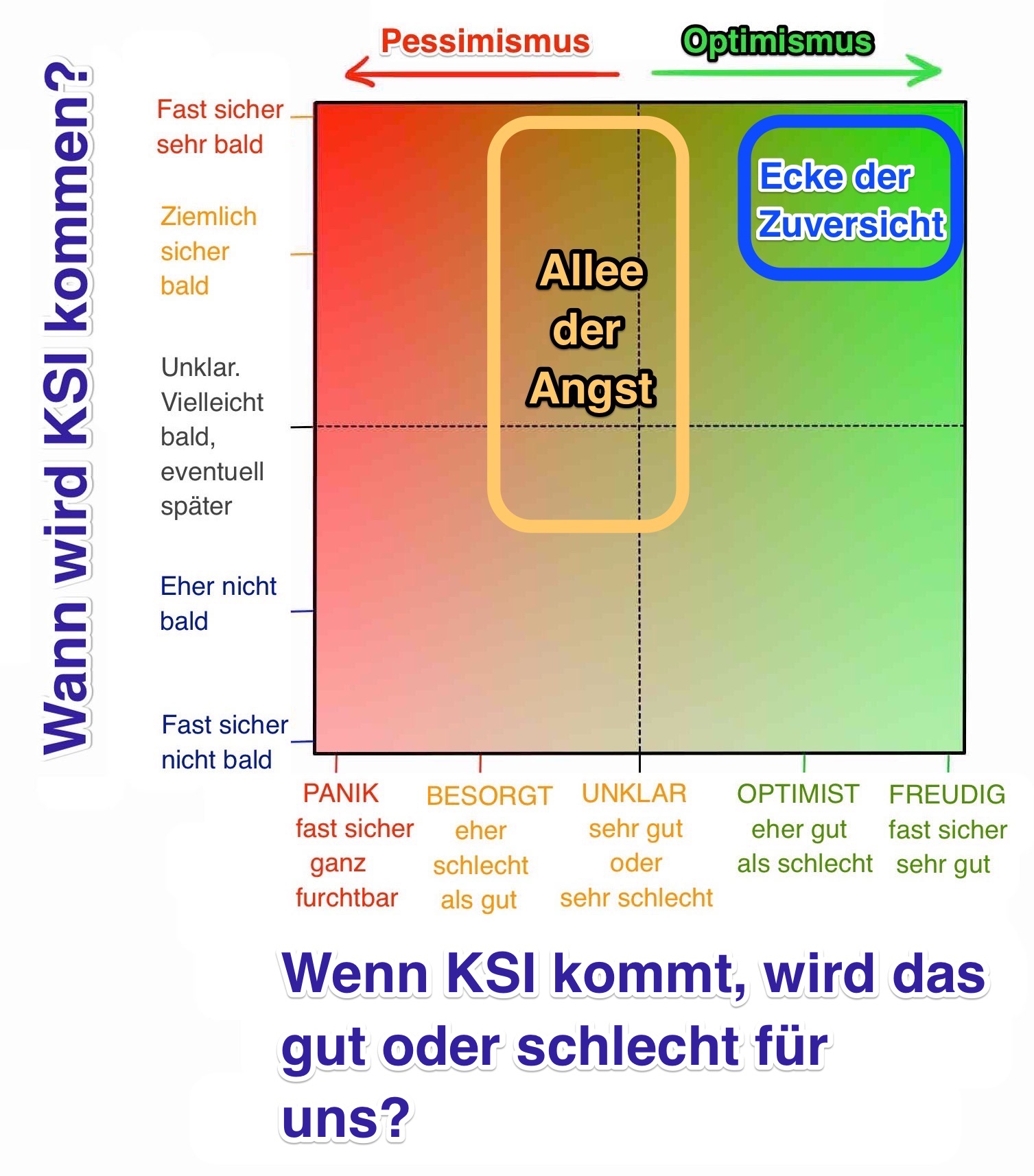

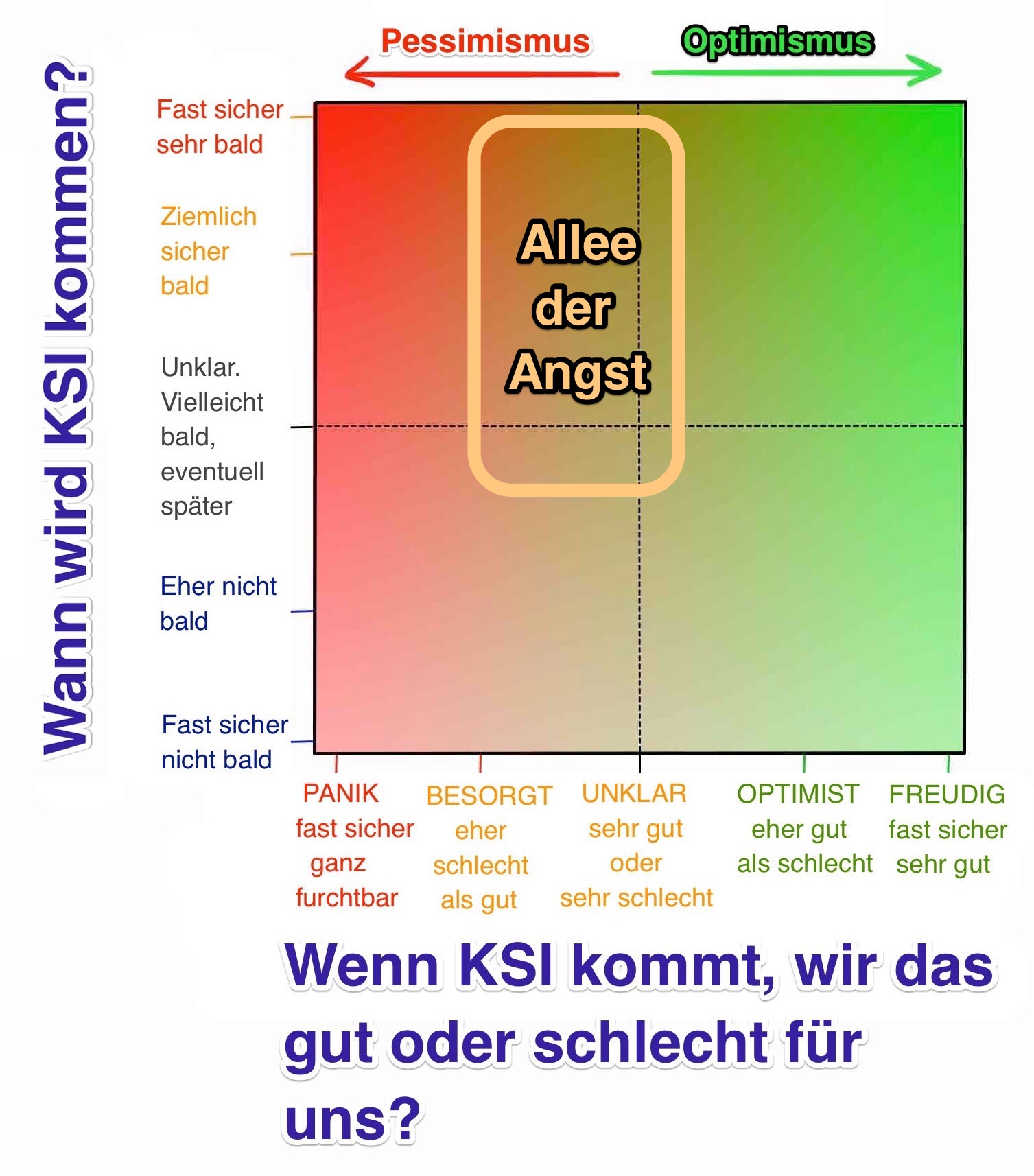

Bemerkenswerterweise fallen über drei Viertel der Experten in zwei Unterlager des Hauptlagers:

Wir werden uns nun intensiv mit diesen beiden Lagern beschäftigen. Fangen wir mit dem Vergnüglichen an:

Warum in Zukunft unsere größten Träume in Erfüllung gehen könnten

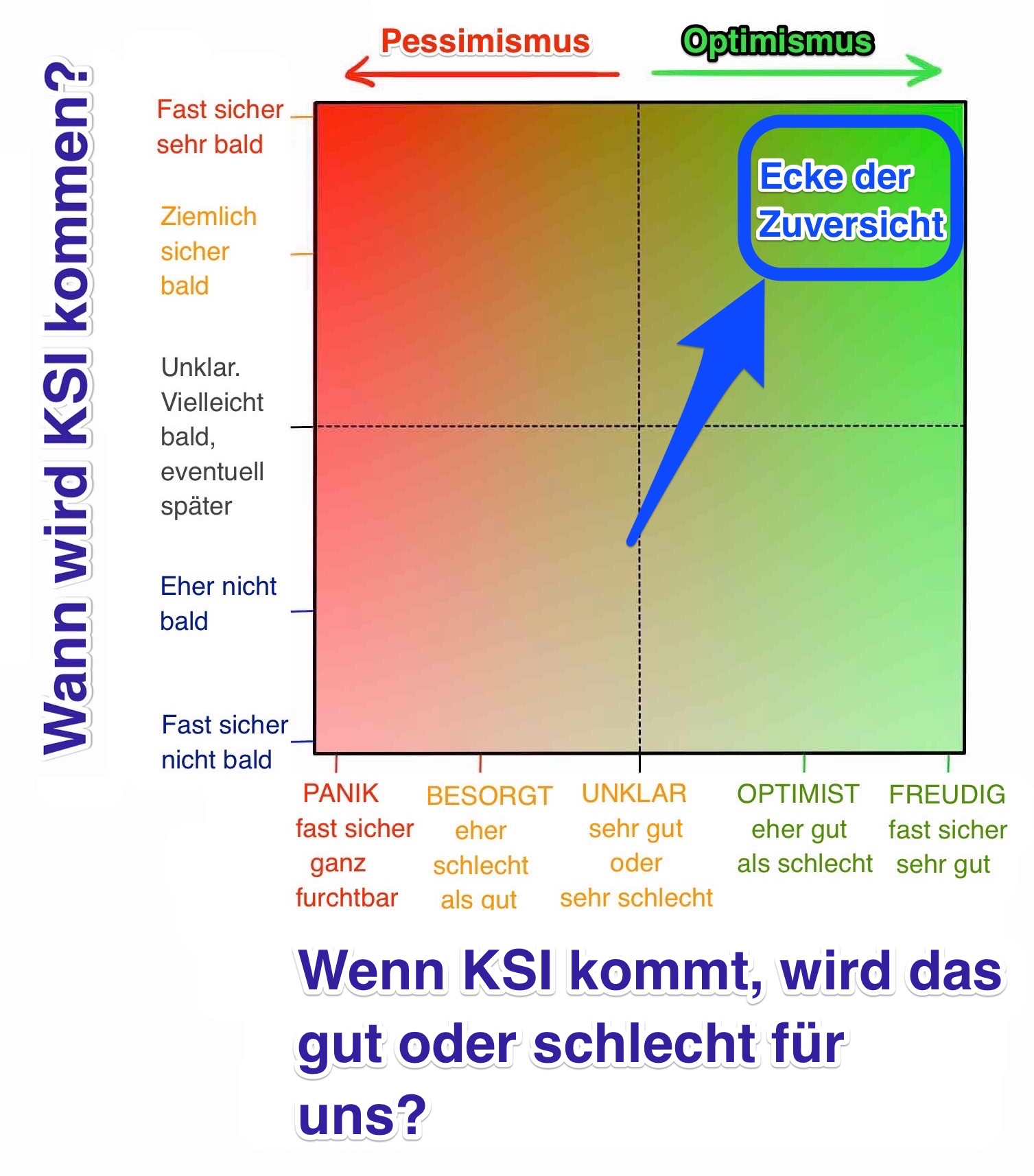

Am Anfang meiner Recherche traf ich auf eine überraschend große Menge an Leuten, die sich hier aufhielten:

Die Leute aus der Zuversichtsecke sprühen vor Begeisterung. Sie haben die vergnügliche Seite des Schwebebalkens fest im Blick und sind überzeugt, dass wir alle dorthin kommen werden. Die Zukunft repräsentiert für sie alles, wovon sie jemals geträumt haben, genauso wie sie es sich wünschen.

Sie unterscheiden sich dabei nicht von den anderen Vordenkern durch ihre Vorfreude auf die glückliche Seite des Balkens – sondern durch ihre feste Überzeugung, dass wir tatsächlich auf dieser Seite landen werden.

Woher diese Zuversicht herrührt, steht zur Diskussion.

Die Kritiker glauben, dass die Zuversichtlichen vor lauter Begeisterung blind und taub für jeden möglichen negativen Ausgang geworden sind. Aber diese erwidern, dass es naiv sei, Weltuntergangsszenarien heraufzubeschwören, da uns Technologie im Großen und Ganzen sehr viel mehr hilft, als es uns schadet – das galt bisher und wird wahrscheinlich auch in Zukunft gelten.

Wir werden beide Seiten abhandeln und du kannst dir dann beim Lesen deine eigene Meinung bilden.

Für diesen Abschnitt möchte ich, dass du deine Skepsis für einen Moment vergisst und dir genau anschaust, was auf der guten Seite des Schwebebalkens zu erwarten ist – und versuchst, zu verinnerlichen, dass diese Dinge tatsächlich so eintreten könnten.

Wenn du einem Jäger und Sammler unsere Welt des häuslichen Komforts, der Technologie und des endlosen Überflusses gezeigt hättest, dann hätte das auf ihn wie Magie gewirkt – und wir müssen bescheiden genug sein und anerkennen, dass möglicherweise eine vergleichbar unvorstellbare Transformation unsere Zukunft sein könnte.

Nick Bostrom beschreibt drei Wege, wie ein superintelligentes KI-System funktionieren könnte:

- Als Orakel, das nahezu jede Frage exakt beantworten kann. Das gilt auch für komplexe Fragen, die Menschen nicht ohne Weiteres beantworten können – z.B. Wie kann ein effizienterer Motor für ein Auto hergestellt werden? Google ist ein primitives Beispiel für ein Orakel.

- Als Flaschengeist, der jede ihm gestellte, allgemeine Anweisung ausführt – Benutze einen nanotechnologischen Assembler um einen neuen und effizienteren Motor für Autos zu bauen. Und dann wartet er auf die nächste Anweisung.

- Als Herrscher, der einen weitgefassten und unbefristeten Auftrag ausführt, frei in der Welt wirken darf und dabei eigene Entscheidungen über sein weiteres Vorgehen trifft – Erfinde eine im Vergleich zu Autos schnellere, günstigere und gefahrlosere Möglichkeit, mit der sich Menschen selbst transportieren können.

Diese Fragen und Aufgaben, die uns schwierig erscheinen, würden für ein superintelligentes System so klingen als würde uns jemand fragen, wie wir die Situation „Mein Stift ist vom Tisch gefallen“ lösen würden – „Aufheben und wieder auf den Tisch legen“ wäre unsere banale Antwort.

Eliezer Yudkowsky, ein Bewohner der Ängstlichen Allee auf unserer obigen Abbildung, hat es sehr gut formuliert:

Es gibt keine schweren Probleme, nur Probleme, die für ein bestimmtes Intelligenzniveau schwer zu lösen sind. Steigere die Intelligenz um das kleinste bisschen und ein Problem wird plötzlich von „unmöglich“ zu „offensichtlich“ wandern. Steigere sie beträchtlich und die Lösung aller Probleme wird offensichtlich werden.

Es gibt eine ganze Reihe eifriger Wissenschaftler, Erfinder und Unternehmer in der Zuversichtsecke – aber für einen Ausflug zur hellsten Stelle im KI-Universum gibt nur eine Person als Fremdenführer.

Ray Kurzweil polarisiert. Über ihn konnte ich allerlei lesen, von gottgleicher Verehrung für ihn und seine Ideen bis zu genervter Verachtung. Andere finden sich irgendwo in der Mitte wieder.

Der Autor Douglas Hofstadter fasste es bei der Besprechung der Ideen aus Kurzweils Büchern in folgende Worte:

Es ist so, als würde man eine Menge sehr gutes Essen und ein wenig Hundescheiße nehmen und beides dann so gründlich mixen, dass man am Ende nicht mehr unterscheiden kann, was nun gut oder schlecht ist.

Ob man es nun gut findet oder nicht, alle sind sich einig, dass Kurzweil beeindruckend ist. Er begann schon als Teenager damit Dinge zu erfinden. Und in den folgenden Jahrzehnten hatte er einige bahnbrechende Einfälle: den ersten Flachbettscanner, den ersten Scanner, der Text in Sprache umwandeln konnte (womit Blinde normale Texte lesen konnten), den bekannten Kurzweil-Synthesizer (das erste wirklich elektrische Piano) und die erste kommerziell vermarktete Spracherkennung mit einem großen Vokabular. Er ist der Autor fünf nationaler Bestseller-Bücher. Er ist bekannt für seine mutigen Vorhersagen und hatte in der Vergangenheit sehr oft recht – dies beinhaltet auch die Vorhersage für das Internet aus den 80ern, als es sich dabei noch um eine obskure Sache handelte, in der er postulierte, dass in den frühen 2000ern das Internet ein globales Phänomen sein würde.

Kurzweil wurde vom Wall Street Journal ein „rastloses Genie“ genannt, von Forbes „die ultimative Denkmaschine“, vom Inc. Magazine „der rechtmäßige Erbe von Edison“ und von Bill Gates „die beste Person bei der Vorhersage der Zukunft der künstlichen Intelligenz, die ich kenne“.

Im Jahr 2012 wurde Kurzweil von Google-Mitgründer Larry Page gebeten, dort den Posten des Director of Engineering zu übernehmen.

Im Jahr 2011 gründete er die Singularity University mit, die auf einem Gelände der NASA beheimatet ist und teilweise von Google finanziert wird.

Nicht schlecht für das Leben eines einzigen Menschen.

Diese Biographie ist wichtig. Kurzweil klingt nämlich wie ein Spinner, wenn er von seiner Vorstellung von der Zukunft spricht. Aber das verrückte ist, dass er so ziemlich das Gegenteil davon ist – er ist ein extrem intelligenter, kenntnisreicher und relevanter Mensch auf dieser Erde.

Vielleicht denkst du, dass er im Hinblick auf die Zukunft falsch liegt, aber er ist kein Dummkopf.

Zu wissen, dass er so ein cooler Typ ist, macht mich glücklich. Denn mir ist in Bezug auf seine Vorhersagen der Zukunft klargeworden, dass ich dringend möchte, dass er recht behält.

Und du möchtest das auch.

Wenn du Kurzweils Vorhersagen hörst, die auch oftmals von anderen Vordenkern aus der Zuversichtsecke wie Peter Diamandis und Ben Goertzel geteilt werden, dann kannst du leicht nachvollziehen, warum er so zahlreiche und glühende Anhänger um sich scharen konnte – die sogenannten Singularitarians.

Nun also was nach Meinung von Kurzweil passieren wird:

Zeitplan

Kurzweil glaubt, dass Computer AKI bis 2029 erreichen und wir bis 2045 nicht nur KSI, sondern eine komplett neue Welt erschaffen werden – eine Zeit, die er die Singularität nennt.

Der von ihm vertretene Ablauf hinsichtlich KI wurde früher von vielen als extrem optimistisch angesehen und das tun immer noch viele.

In den letzten 15 Jahren hat sich aber durch die schnellen Fortschritte im Bereich der EKI-Systeme die Meinung einer breiteren Masse von KI-Experten immer weiter an Kurzweils Ansichten angenähert. Seine Vorhersagen sind immer noch etwas ambitionierter als die des Median-Teilnehmers in der Umfrage von Müller und Bostrom (AKI bis 2040, KSI bis 2060), aber auch nicht mehr allzu weit entfernt.

Kurzweils Darstellung der Singularität im Jahr 2045 wird durch drei gleichzeitig stattfindende revolutionäre Entwicklungen in der Biotechnologie, der Nanotechnologie und – am mächtigsten – der KI herbeigeführt.

Bevor wir fortfahren – Nanotechnologie findest du fast überall, wenn du über die Zukunft der KI liest, also schau dir die graue Box für einen Augenblick an, damit wir darüber diskutieren können.

[box type=“shadow“ ]Graue Box: NanotechnologieMit Nanotechnologie bezeichnen wir jene Technologie, die sich mit der Manipulation von Materie beschäftigt, die zwischen 1 und 100 Nanometern groß ist.

Ein Nanometer ist ein Milliardstel Meter oder ein Millionstel Millimeter. In dieser Bandbreite (1-100) befinden sich Viren (100nm quer), DNA (10nm breit) und Dinge, die so klein sind wie große Moleküle, z.B. Hämoglobin (5nm) und mittlere Moleküle wie Glukose (1nm).

Wenn/Sobald wir die Nanotechnologie beherrschen, wird der nächste Schritt die Fähigkeit sein, einzelne Atome zu manipulieren, die nur eine Größenordnung kleiner sind (~.1nm).

Um zu veranschaulichen, was für eine große Herausforderung das für die Menschheit darstellt, möchte ich das ganze auf einen größeren Maßstab übertragen.

Die Internationale Raumstation ISS ist 268 Meilen (431km) von der Erde entfernt. Wenn Menschen so groß wären, dass ihr Kopf die ISS berühren könnte, dann wären sie 250.000-mal größer als sie tatsächlich sind.

Wenn du die Spanne von 1nm bis 100nm 250.000-mal vergrößerst, dann ergeben sich 0,25mm bis 2,5cm.

Nanotechnologie entspricht also dem Versuch eines Riesen, der bis zur ISS reicht und versucht, komplizierte Objekte aus Materialien zu bauen, die so groß sind wie ein Sandkorn und ein Augapfel.

Um das nächste Niveau zu erreichen – einzelne Atome – müsste der Riese Objekte manipulieren, die 1/40stel Millimeter groß sind. Eine Größe, für die normale Menschen ein Mikroskop benötigen, um sie zu sehen.

Nanotechnologie wurde zuerst von Richard Feynman im Jahr 1959 im Rahmen eines Vortrags erörtert. Er erklärte Folgendes:

„Die Prinzipien der Physik sprechen, soweit ich das sehen kann, nicht gegen die Möglichkeit, einzelne Atome zu bewegen. Es wäre, im Prinzip, möglich … dass ein Physiker jede chemische Substanz, die ein Chemiker niederschreibt, künstlich herstellen kann … Wie? Stelle die Atome an den Platz, den der Chemiker vorgibt, und schon hast du die Substanz.“

So einfach ist das. Wenn es gelingt, einzelne Atome zu bewegen, kann man im wahrsten Sinne des Wortes alles herstellen.

Innere Box: Das Graue-Schmiere-Szenario

Wir befinden uns nun auf der Abschweifung von der Abschweifung. Das wir lustig.

Aber egal, ich habe dich hierhin geführt, weil es einen wirklich ernsten Teil in dem Märchen von der Nanotechnologie gibt, den ich mit dir besprechen muss.

In älteren Versionen der Nanotechnologie- Theorie wurde eine Methode zur Nano-Montage vorgeschlagen, in der Billionen von Nano-Robotern zusammenarbeiten, um gemeinsam etwas zu bauen. Ein Weg, um Billionen von Nano-Bots zu erschaffen, wäre einen zu bauen, der sich selbst replizieren kann. Dann würden sich der Erste verdoppeln, dann entstünden 4, dann 8 und nach etwas über einem Tag hätte man einige Billionen.

Die Macht exponentiellen Wachstums.

Schlau, nicht wahr?

Es ist schlau, bis man dabei versehentlich eine gigantische und vollständige, erdumspannende Apokalypse auslöst.

Das Problem entsteht durch das exponentielle Wachstum, das dafür sorgt, dass man sehr bequem Billionen von Nano-Bots erzeugen kann. Dadurch wird Selbstreplikation zu einer Grauen erregenden Aussicht.

Denn was passiert, wenn sich ein Fehler in den Prozess einschleicht, der dafür sorgt, dass der Prozess nach den ersten paar Billionen Nano- Bots nicht endet, sondern einfach fortfährt?

Die Nano-Bots würden bestimmungsgemäß alle kohlenstoffbasierten Materialien konsumieren, um den Dummerweise basiert alles Leben auf Kohlenstoff.

Die Biomasse der Erde besteht aus 1045 Kohlenstoff-Atomen. Ein Nano-Bot bestünde aus 106 Kohlenstoff-Atomen. 1039 Nano-Bots würden also das gesamte Leben auf der Erde verschlingen, was in 130 Replikationsschritten vollzogen werden würde (2130 entspricht etwa 1039).

Dabei würde ein Meer von Nano-Bots die Welt überschwemmen, daher der Begriff Graue Schmiere.

Wissenschaftler schätzen, dass sich ein Nano-Bot in etwa 100 Sekunden replizieren könnte, was dazu führt, dass ein einfacher Fehler alles Leben auf der Erde in 3,5 Stunden unpraktischerweise beenden könnte.

Ein noch schlimmeres Szenario wäre, wenn Terroristen auf irgendwelchen Wegen Zugang zur Nano-Technologie bekämen und in der Lage wären, die Nano-Bots zu programmieren. Dann könnten sie einige Billionen davon herstellen und dafür sorgen, dass diese sich klammheimlich weltweit verbreiten.

Und erst dann würden sie alle simultan aktiv werden und die Welt in etwa 90 Minuten konsumieren – durch ihre gleichmäßige Verteilung bestünde dann kein Weg, sie zu stoppen.

Obwohl diese Horror-Geschichte seit Jahren diskutiert wird, ist dieses Szenario wohl überzogen

Eric Drexler, der den Begriff Graue-Schmiere-Szenario geprägt hat, hat mir auf diesen Artikel folgende Email geschrieben: „Die Leute lieben beängstigende Geschichten, und diese gehört zu den Zombies. Die Idee an sich zerfrisst Gehirne.“

Sobald wir Nanotechnologie wirklich beherrschen, können wir damit vieles herstellen: technische Geräte, Kleidung, Nahrung, eine Vielzahl biologischer Produkte – künstliche Blutzellen, winzige Zerstörer für Viren oder Krebszellen, Muskelgewebe, usw. – im Grunde alles.

Und in einer Welt mit Nanotechnologie sind die Kosten eines Materials nicht mehr an dessen Knappheit oder die Schwierigkeit des Herstellungsprozesses gebunden, sondern hängen nur noch von der Komplexität der atomaren Strukturen ab.

In dieser Welt könnte ein Diamant billiger sein als ein Radiergummi.

Aber an diesem Punkt sind wir noch nicht. Und es ist unklar, ob wir die Schwierigkeit des Weges dorthin über- oder unterschätzen. Aber wir scheinen nicht allzu weit entfernt zu sein.

Kurzweil schätzt, dass wir in den 2020ern dort ankommen werden.

Die Regierenden wissen, dass Nanotechnologie die Erde kräftig durchschütteln würde und haben Milliarden Dollar in die Nanotechnologie-Forschung investiert (die USA, die EU und Japan haben bisher insgesamt 5 Milliarden Dollar investiert).

Wenn man die Möglichkeiten betrachtet, die ein superintelligenter Computer mit Zugang zu einem robusten nanotechnologischen Assembler bieten würde, dann entstehen bei mir starke Gefühle.

Aber Nanotechnologie haben wir bereits erfunden, wir sind unterdessen dabei es zu meistern.

Weil aber alles, wozu wir in der Lage sind, ein Witz im Vergleich zu den Möglichkeiten eines KSI-Systems ist, müssen wir davon ausgehen, dass eine KSI weitaus mächtigere Nanotechnologien erfinden würde, die wir mit unserem menschlichen Gehirn auch nicht mehr verstehen würden.

Aus diesem Grund können wir gar nicht das Ausmaß der Konsequenzen einer erfolgreichen und gutartigen KI- Revolution unterschätzen.

Wenn dir die nun folgenden Vorhersagen für eine Zukunft mit KSI völlig überzogen erscheinen, dann behalte im Hinterkopf, dass das alles Wirklichkeit werden könnte, aber auf Wegen, die wir uns gar nicht vorstellen können.

Höchstwahrscheinlich sind unsere Gehirne nicht einmal in der Lage vorherzusagen, was passieren würde.[/box]

Was KI für uns tun könnte

KSI würde durch ihre Superintelligenz und all die Technologie, die sie mit Hilfe ihrer Superintelligenz erschaffen kann, wahrscheinlich alle Probleme der Menschheit lösen.

Klimawandel? Eine KSI könnte zuerst den Ausstoß von CO2 stoppen, indem sie deutlich bessere Arten der Energieerzeugung erfindet, die nicht auf fossilen Brennstoffen basieren. Dann könnte sie innovative Möglichkeiten erfinden, überschüssiges CO2 aus der Atmosphäre zu entfernen.

Krebs und andere Krankheiten? Kein Problem für KSI – das Gesundheitswesen und die Medizin bekämen Möglichkeiten, die jenseits unserer Vorstellungskraft liegen.

Welthunger? KSI könnte Nanotechnologie einsetzen, um Fleisch zu bauen. Dieses Fleisch wäre auf molekularer Ebene identisch mit echtem Fleisch – oder anders formuliert: es wäre echtes Fleisch. Nanotechnologie könnte einen Haufen Abfälle in einen großen Berg frisches Fleisch oder anderes Essen verwandeln, das nicht einmal dessen normale Form haben müsste – man stelle sich einen gigantischen Apfelwürfel vor. Und diese Nahrungsmittel könnten mit ultra-fortschrittlichen Transportmitteln weltweit verteilt werden. Natürlich wäre das auch großartig für alle Tiere, die vom Menschen nicht mehr als Nahrung getötet werden müssten.

Eine KSI könnte darüber hinaus auch noch viele andere Dinge für vom aussterben bedrohte Tierarten erreichen, vielleicht sogar ausgestorbene Spezies aus erhaltener DNA wieder zum Leben erwecken.

KSI könnte sogar unsere komplexesten Makro-Probleme lösen – wie Ökonomien am besten gesteuert werden sollten, wie der Welthandel am besten organisiert werden sollte oder unsere ungelösten Probleme der Philosophie und der Ethik – das alles wäre nur zu offensichtlich für eine KSI.

Es gibt aber noch eine Sache, die KSI für uns erreichen könnte, deren Aussicht so verlockend ist, dass sich dadurch mein ganzes Weltbild verschoben hat.

KSI könnte uns helfen, unsere Sterblichkeit zu besiegen

Vor einigen Monaten sprach ich über meinen Neid gegenüber fortschrittlicheren und vorstellbaren Zivilisationen, die ihre eigene Sterblichkeit besiegen konnten. Niemals hätte ich es für möglich gehalten, dass ich später einen Artikel schreiben könnte, der mich zu der Überzeugung führen würde, dass Unsterblichkeit in meiner Lebenszeit von uns Menschen erreicht werden könnte.

Aber die Beschäftigung mit KI wird alle deine Überzeugungen in Frage stellen – einschließlich deiner Vorstellungen über den Tod.

Die Evolution hatte keinen guten Grund, unsere Lebenszeit weiter als den heutigen Stand auszubauen. Wir leben lange genug, um uns fortzupflanzen und unsere Kinder in ein selbständiges Leben zu führen. Das reicht der Evolution.

Aus evolutionärer Sicht ist unsere Spezies mit 30+ Jahren sehr erfolgreich. Es gibt also keinen Grund, warum Mutationen mit ungewöhnlich langer Lebensspanne bei der natürlichen Selektion überlegen sein sollten.

Das führt dazu, dass wir in den Worten von W.B. Yeats „eine in einem sterbenden Tier gefangene Seele“ sind.

Kein großer Spaß. Und weil jeder bisher gestorben ist, leben wir unter der „Tod und Steuern“-Annahme, die besagt, dass der Tod unvermeidlich sei.

Wir denken über das Altern wie über die Zeit – beide laufen weiter und man kann nichts tun, um sie zu stoppen.

Aber diese Annahme ist falsch.

Richard Feynman schreibt:

Es ist eine der bemerkenswertesten Tatsachen, dass es in keiner der biologischen Wissenschaften einen Hinweis auf die Notwendigkeit des Todes gibt. Wenn du sagst, dass wir ewige Bewegung erzeugen wollen, dann kennen wir genug Gesetze aus dem Studium der Physik, um zu sehen, dass dies entweder unmöglich ist oder die Gesetze nicht gelten. Aber in der Biologie wurde noch nichts entdeckt, dass die Unvermeidbarkeit des Todes nahelegt. Dies legt für mich nahe, dass es nur eine Frage der Zeit ist, bis die Biologen entdecken, was es ist, dass uns diese Probleme verursacht und dass diese universelle, schreckliche Krankheit oder der vorübergehende Charakter des menschlichen Körpers geheilt wird.

Tatsächlich ist das Altern nicht fest an die Zeit gebunden. Die Zeit wird immer weiter fortschreiten, aber das Altern muss das nicht.

Wenn du darüber nachdenkst, dann ist das auch logisch. Das Altern ist nur die Abnutzung der physikalischen Materialien des Körpers. Ein Auto nutzt sich mit der Zeit auch ab – aber ist das Altern unvermeidbar? Wenn du jedes abgenutzte Teil eines Autos perfekt reparieren oder austauschen würdest, dann würde das Auto ewig laufen. Der menschliche Körper ist genauso – nur deutlich komplexer.

Kurzweil spricht von intelligenten, WLAN-fähigen Nano-Robotern im Blutkreislauf, die unzählige Aufgaben für die menschliche Gesundheit übernehmen könnten, einschließlich der Reparatur und des Austausches von abgenutzten Zellen in jedem Teil des Körpers.

Im Extremfall könnte dieser Prozess (oder ein anderer Prozess, den eine überlegene KSI erfinden könnte) nicht nur die Gesundheit des Körpers erhalten, es könnte den Alterungsprozess umkehren. Der Unterschied zwischen dem Körper eines 60-Jährigen und dem Körper eine 30- Jährigen besteht nur in einer Reihe körperlicher Dinge, die wir umkehren könnten, wenn wir die entsprechende Technologie hätten.

KSI könnte eine Verjüngungsmaschine bauen, in die ein 60-Jähriger hineingehen könnte, um mit dem Körper und der Haut eines 30-Jährigen wieder herauszukommen.

Sogar das allzeit faszinierende Gehirn könnte von etwas, das so schlau ist wie eine KSI, verjüngt werden. Denn KSI könnte einen Weg finden, die Daten des Gehirns (Persönlichkeit, Erinnerungen, usw.) dabei nicht zu beeinträchtigen.

Ein 90-Jähriger, der an Demenz leidet, könnte in die Verjüngungsmaschine spazieren und als Mensch mit einem klaren Verstand herauskommen, der nur darauf wartet eine gänzlich neue Karriere zu beginnen.

Das scheint absurd – aber der Körper ist nur ein Haufen Atome und KSI wäre in der Lage, alle möglichen atomaren Strukturen zu manipulieren – es ist überhaupt nicht absurd.

Kurzweil spinnt die Geschichte aber noch einen großen Schritt weiter. Er glaubt, dass künstliche Materialien im Lauf der Zeit immer stärker in den Körper integriert werden. Zuerst könnten die Organe durch super-fortschrittliche Maschinen ersetzt werden, die ewig funktionieren und niemals versagen.

Danach könnten wir, so glaubt Kurzweil, damit beginnen, den Körper neu zu gestalten.

Er denkt daran, die roten Blutkörperchen mit perfekten Nano-Robotern zu ersetzten, die sich selbständig bewegen können und damit die Notwendigkeit eines Herzens vollständig eliminieren.

Er schließt auch das Gehirn nicht aus und glaubt, dass wir die Gehirnaktivitäten verbessern werden. Bis zu dem Punkt, an dem wir milliardenfach schneller denken werden und auf externe Informationen zugreifen können, weil die künstlichen Erweiterungen des Gehirns auf das gesamte Wissen der Cloud Zugriff haben.

Die Möglichkeiten für neue menschliche Erfahrungen wären unbegrenzt.

Die Menschen haben Sex von seiner eigentlichen Bestimmung getrennt, wodurch sie Sex zum Vergnügen haben können, ohne sich auf die Fortpflanzung zu beschränken.

Kurzweil denkt, dass uns das gleiche mit unserer Ernährung gelingen wird. Nano-Roboter werden dafür verantwortlich sein, die perfekte Ernährung zu den Zellen unseres Körpers zu transportieren. Dabei werden sie intelligent genug vorgehen, um alles Ungesunde direkt durch den Organismus zu schleusen, sodass kein Schaden entstehen kann. Ein Ess-Kondom.

Der Nanotechnologie- Theoretiker Robert A. Freitas hat schon einen Ersatz für rote Blutkörperchen entwickelt, der es einem Menschen erlauben würde, wenn er eines Tages im Körper implementiert wird, 15 Minuten ohne einen einzigen Atemzug zu sprinten – man kann sich also leicht vorstellen, was eine KSI für unsere körperlichen Fähigkeiten erreichen könnte.

Virtuelle Realität bekäme eine ganz neue Bedeutung.

Nano-Roboter in unserem Körper könnten die Sinneseindrücke von unseren Sinnesorganen unterdrücken und stattdessen völlig andere Signale erzeugen, die uns in eine neue Umgebung versetzten, die wir hören, sehen und riechen würden.

Schlussendlich glaubt Kurzweil, dass wir Menschen einen Punkt erreichen werden, an dem wir komplett künstlich sein werden.

Dann werden wir biologische Materialen in einem ganz neuen Licht sehen, und uns wundern, dass wir Menschen jemals aus etwas so unglaublich primitiven bestanden; wir werden es kaum glauben können, dass in der Frühgeschichte des Menschen Mikroben, Unfälle oder Krankheiten einen Menschen gegen seinen Willen töten konnten.

Geschichten aus einer Zeit, die durch die KI-Revolution und das Verschmelzen von Menschen und KI beendet wurde.

Kurzweil glaubt, dass wir auf diesem Weg unzerstörbar und unendlich werden – das ist seine Vision für die andere Seite des Schwebebalkens.

Und er ist überzeugt, dass wir das erreichen werden. In naher Zukunft.

Es überrascht dich wahrscheinlich nicht, dass Kurzweils Ideen starke Kritik hervorrufen. Seine Vorhersage für die Singularität im Jahr 2045 und das danach mögliche, ewige Leben für Menschen wurde verspottet als „Rausch der Nerds“ oder „Intelligent-Design für Leute mit einem IQ von 140.“

Andere stellen seine optimistische Zeitschiene in Frage, oder sein Verständnis des menschlichen Körpers und Gehirns, oder seine Anwendung des Mooreschen Gesetzes, das normalerweise auf den Fortschritt von Hardware bezogen wird und nicht auf eine weite Klasse von Dingen einschließlich Software.

Auf jeden Experten, der inbrünstig glaubt, dass Kurzweil richtigliegt, gibt es wahrscheinlich drei, die denken, dass er völlig danebenliegt.

Am stärksten überrascht hat mich die Tatsache, dass selbst die Experten, die ihm nicht zustimmen, nicht wirklich abstreiten, dass alles, was er sagt, möglich ist.

Ich nahm an, dass viele seine obskuren Visionen mit den Worten „Das kann natürlich niemals so eintreten“ abtun würden, stattdessen sagen sie aber zum Beispiel „Ja, das alles kann passieren, wenn wir den Übergang zu KSI sicher bewerkstelligen, aber das ist der schwierige Teil.“

Bostrom, einer der prominentesten Mahner vor den Gefahren der KI, räumt ein: Es fällt schwer, sich ein Problem auszudenken, das nicht von einer Superintelligenz gelöst werden könnte oder das zumindest wir mit dessen Hilfe lösen könnten.

Krankheiten, Armut, Umweltzerstörung, unnötiges Leid aller Art: diese Dinge könnte eine mit fortschrittlicher Nanotechnologie ausgestattete Superintelligenz eliminieren.

Zusätzlich könnte uns eine Superintelligenz unendliche Lebenszeit bescheren, entweder durch das Anhalten oder die Umkehr des Alterungsprozesses mit der Hilfe von Nano-Medizin, oder indem die Möglichkeit entsteht, uns selbst hochzuladen.

Eine Superintelligenz könnte auch die Möglichkeit erschaffen, unsere intellektuellen und emotionalen Fähigkeiten dramatisch auszubauen, und es könnte uns dabei unterstützen, sehr anziehende, experimentelle Welten zu schaffen, in denen wir ein Leben mit freudebringenden Spielen, in Beziehung zueinander, voller Erleben und persönlichem Wachstum und näher an unseren Idealen verbringen könnten.

Dieses Zitat stammt von jemandem, der absolut nicht in der Zuversichtsecke steht.

Aber genau darauf stieß ich immer wieder – Experten, die über Kurzweil aus verschiedensten Gründen spotten, aber die nicht denken, dass seine Aussagen unmöglich sind, wenn wir es sicher bis zu KSI schaffen.

Deswegen finde ich Kurzweils Ideen so ansteckend – weil sie die sonnige Seite der Geschichte erzählen und weil sie tatsächlich möglich sind. Wenn es ein freundlicher Gott ist.

Die hervorstechendste Kritik der Vordenker aus der Zuversichtsecke bezieht sich darauf, dass sie gefährlich falsch liegen, wenn es um die Bewertung der Schattenseite von KSI geht.

Kurzweils berühmtes Buch Menschheit 2.0: Die Singularität naht umfasst 700 Seiten und er widmet sich 20 Seiten lang den möglichen Gefahren.

Ich habe vorher noch gesagt, dass unser Schicksal, wenn diese gigantische neue Macht entsteht, entscheidend davon abhängt, wer diese Macht kontrolliert und was dessen Motivation sein wird.

Kurzweil beantwortet beide Teile dieser Frage geschickt mit dem folgenden Satz: „[KSI] entsteht aus vielen verschiedenen Anstrengungen und wird tief in die Infrastruktur unserer Zivilisation verwoben sein. Tatsächlich wird sie aufs Engste in unsere Gehirne und Körper eingebunden sein. Von daher wird es unsere Werte reflektieren, weil wir es sein werden.“

Wenn das aber die Antwort ist, warum sind dann viele der klügsten Menschen der Welt so besorgt im Moment?

Warum denkt Stephen Hawking, die Entwicklung von KSI „könnte das Ende der Menschheit bedeuten“? Und Bill Gates sagt, dass er nicht „versteht, warum manche Menschen nicht besorgt sind“ und Elon Musk befürchtet, dass wir „den Teufel heraufbeschwören“.

Und warum bezeichnen so viele Experten aus diesem Feld KSI als die größte Gefahr für die Menschheit?

Diese Menschen und die anderen Vordenker der Ängstlichen Allee sind nicht davon überzeugt, wie Kurzweil die Gefahren der KI vom Tisch wischt. Sie sind sehr, sehr besorgt über die KI-Revolution und sie konzentrieren sich nicht auf die gute Seite des Schwebebalkens. Sie sind zu sehr damit beschäftigt auf die andere Seite zu starren, wo sie eine Grauen erregende Zukunft erkennen, bei der sie nicht sicher sind, ob wir ihr entkommen können.

—

Warum die Zukunft unser größter Albtraum werden könnte

Einer der Gründe, warum ich mehr über KI lernen wollte, war, dass mich das Thema des „bösartigen Roboters“ immer verwirrt hat. Die Filme über böse Roboter erschienen mir immer völlig unrealistisch und ich konnte mir nicht vorstellen, wie KI in der Realität wirklich gefährlich sein könnte.

Roboter werden von uns geschaffen, warum würden wir sie also auf eine Art entwickeln, bei der etwas Negatives passieren könnte? Würden wir nicht genügend Schutzmaßnahmen schaffen? Könnten wir nicht einfach die Stromversorgung eines KI- Systems trennen? Warum sollte ein Roboter überhaupt etwas Böses wollen? Warum sollte ein Roboter überhaupt irgendetwas „wollen“?

Ich war sehr skeptisch.

Aber dann hörte ich immer wieder sehr kluge Leute darüber sprechen… Diese Leute hielten sich meistens irgendwo hier auf:

Die Leute in der Ängstlichen Allee sind nicht in der Prärie der Panik oder den Hügeln der Hoffnungslosigkeit – dies wären Regionen deutlich weiter links auf der Abbildung – aber sie sind nervös und angespannt.

In der Mitte der Abbildung zu stehen, bedeutet nicht, dass man denkt, das KSI neutral sein wird – die Neutralen haben ein eigenes Lager – es bedeutet, dass du denkst, das beide Szenarien (extrem positiv und extrem negativ) plausibel sind, du aber nicht sicher bist, in welche Richtung es gehen wird.

Ein Teil dieser Leute sprudelt vor Begeisterung, wenn sie an die Möglichkeiten von Künstlicher Superintelligenz denken – aber sie sind ein bisschen besorgt, dass es wie der Anfang von Jäger des verlorenen Schatzes sein könnte und die Menschheit ist dieser Typ:

Und er steht da, zufrieden mit seiner Peitsche und seinen Götzen, denkt, dass er alles versteht, ist begeistert von sich selbst, während er „Adios Señor“ sagt … bis er plötzlich weniger begeistert ist, weil folgendes passiert…

(Sorry)

Währenddessen schafft es Indiana Jones, der viel klüger und umsichtiger ist und die Gefahren viel besser versteht und weiß, wie man sie vermeidet, unbeschadet aus der Höhle.

Und wenn ich die Leute aus der Ängstlichen Allee über KI sprechen höre, dann klingt das für mich oft so: „Also, wir sind gerade irgendwie der erste Typ und wir sollten stattdessen wahrscheinlich mit aller Kraft versuchen, Indiana Jones zu sein.“

Also was ist es genau, dass alle in der Ängstlichen Allee so ängstlich macht?

Zuerst einmal, im allgemeinen Sinne, werden wir mit der Entwicklung superkluger KI etwas erschaffen, dass alles verändern und uns in völlig unbekanntes Terrain führen wird. Und wir haben keine Idee, was ab dann passieren wird.

Der Wissenschaftler Danny Hillis vergleicht es mit dem Augenblick „als sich einzellige Organismen in mehrzellige Organismen verwandelt haben. Wir sind Amöben und wir können nicht begreifen, was für ein Ding wir da gerade erschaffen.“

Nick Bostrom ist besorgt, dass die Erschaffung von etwas, das klüger ist als man selbst ein grundlegender Darwinscher Fehler ist. Er vergleicht das mit der Begeisterung einiger Spatzen in einem Nest, die ein Eulenbaby adoptieren. In der Hoffnung, dass sie davon später beschützt werden. Sie ignorieren aber die verzweifelten Schreie einiger Spatzen, die sich fragen, ob das Ganze zwingend eine gute Idee ist…

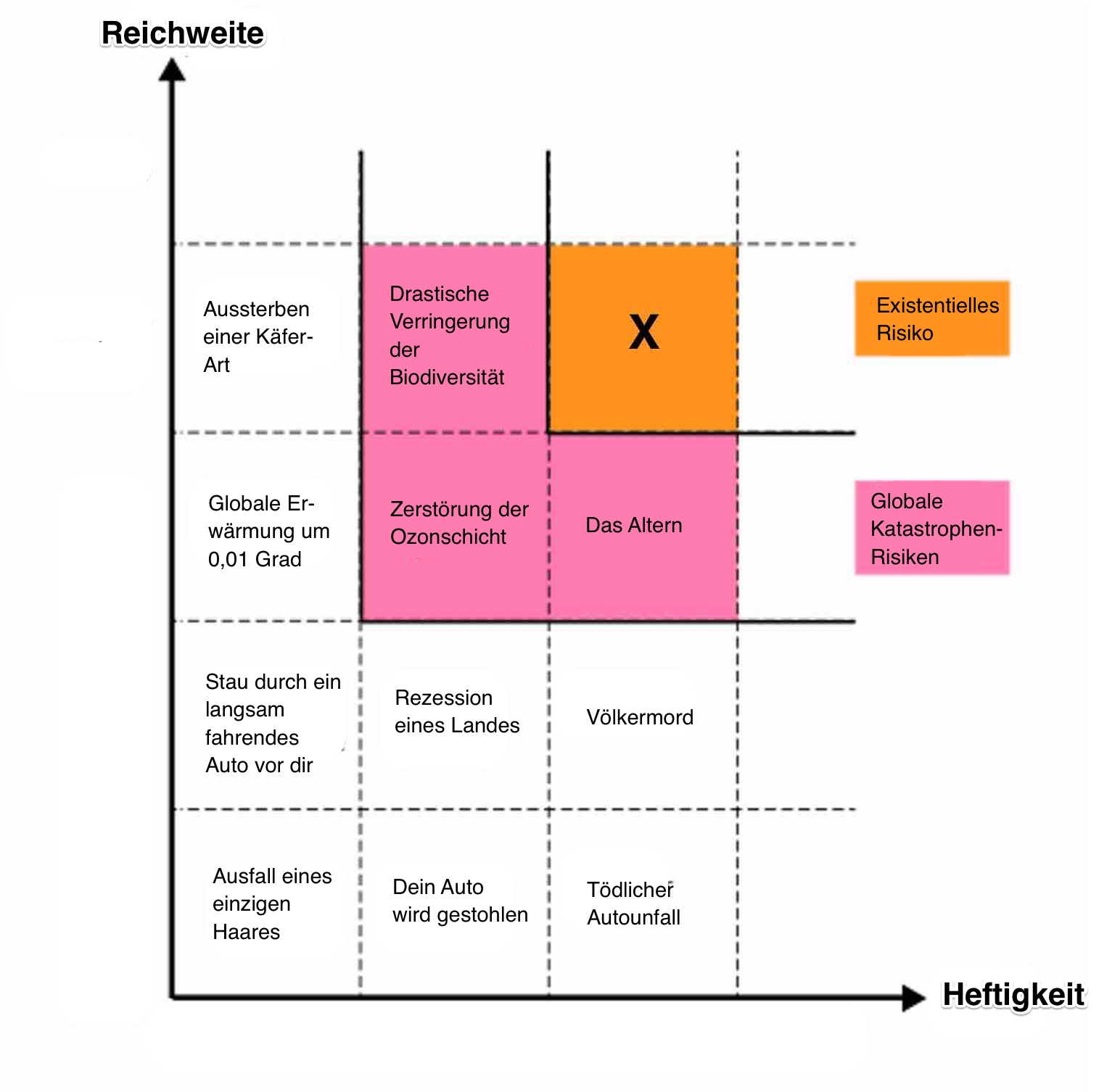

Und wenn man „unbekanntes, schlecht verstandenes Gebiet“ mit „das sollte große Auswirkungen mit sich bringen, wenn es passiert“ kombiniert, dann öffnet man die Türe für die zwei angsteinflößendsten Wörter der deutschen Sprache: Existenzielles Risiko.

Ein existenzielles Risiko kann einen dauerhaft zerstörerischen Einfluss auf die Menschheit haben. Typischerweise bedeutet existenzielles Risiko das Aussterben. Schau dir die Grafik von Bostrom aus seinem Vortrag bei Google an:

Du siehst, dass die Bezeichnung „existenzielles Risiko“ reserviert ist für etwas, dass die ganze Spezies betreffen, Generationen überdauern (also permanent sein) und verheerend oder tödlich sein muss.

Technisch beinhaltet dies auch eine Situation, in der alle Menschen dauerhaft in einem Zustand des Leidens oder der Folter sind, aber nochmal, wir sprechen normalerweise über das Aussterben.

Es gibt drei Dinge, die für Menschen eine existenzielle Katastrophe verursachen können:

- Die Natur – der Aufprall eines großen Asteroiden, eine Veränderung der Atmosphäre, welche die Luft als Lebensraum für Menschen unbrauchbar macht, eine tödliche Virenerkrankung oder auch Bakterien, welche die Welt leerfegen, usw.

- Außerirdische – darauf beziehen sich Stephen Hawking, Carl Sagan und zahlreiche Astronomen, wenn sie Angst davor haben, dass das METI-Projekt Außerirdische anlockt. Sie wollen nicht die amerikanischen Ureinwohner sein, welche die europäischen Eroberer auf sich aufmerksam machen.

- Menschen – Terroristen mit Waffen, mit denen man die Menschheit ausrotten könnte, ein katastrophaler Weltkrieg oder Menschen, die hastig etwas Klügeres als sie selbst erschaffen, ohne zuerst gründlich darüber nachzudenken…

Bostrom vermutet, weil uns Nummer 1 und Nummer 2 in den ersten 100.000 Jahren als Spezies noch nicht ausgelöscht haben, dass diese beiden in den nächsten 100 Jahren auch nicht eintreten werden. Nummer 3 jedoch, dass versetzt ihn in Schrecken.

Er zeichnet als Metapher eine Urne, die zahlreiche Murmeln enthält. Sagen wir, dass die meisten Murmeln weiß sind, eine kleine Anzahl ist rot und einige wenige sind schwarz. Jedes mal, wenn Menschen etwas erfinden, dann ziehen sie eine Murmel aus der Urne. Die meisten Erfindungen sind neutral oder hilfreich für die Menschheit – das sind die weißen Murmeln. Einige sind schädlich für die Menschheit, wie Massenvernichtungswaffen. Aber sie stellen keine existenzielle Gefahr dar – das sind die roten Murmeln.

Wenn wir jemals etwas erfinden sollten, dass zu unserem Aussterben führt, dann hätten wir eine seltene, schwarze Murmel gezogen.

Bisher haben wir noch keine schwarze Murmel gezogen – du erkennst das daran, dass du am Leben bist und diesen Artikel liest.

Aber Bostrom denkt nicht, dass es unmöglich ist, eine schwarze Murmel in der nahen Zukunft zu ziehen.

Wären Atomwaffen beispielsweise einfach herzustellen und nicht extrem schwierig und kompliziert, dann hätten Terroristen die Menschheit schon vor geraumer Zeit zurück in die Steinzeit gebombt. Atomwaffen waren keine schwarze Murmel, aber sie waren verdammt nah dran.

KSI ist nach Bostrom der bisher heißeste Kandidat für eine schwarze Murmel.

Du wirst also von vielen vorstellbaren, schlechten Dingen hören, die durch KSI passieren könnten – galoppierende Arbeitslosigkeit, weil immer mehr Arbeit von KI übernommen wird, Bevölkerungsexplosion, wenn es uns gelingt, das Altern zu überwinden, usw.

Das einzige Risiko mit dem wir uns aber intensiv beschäftigen sollten, bleibt die grandiose Sorge: die Perspektive des existenziellen Risikos. Dies führt uns wieder zu der Schlüsselfrage des früheren Artikels zurück: Wenn KSI da ist, wer oder was wird diese enorme neue Macht kontrollieren, und was wird dessen Motivation sein?

Wenn man darüber nachdenkt, welche Kombination von Agent und Motivation richtig schlecht wären, dann fallen mir sofort ein: ein bösartiger Mensch, eine Gruppe von bösartigen Menschen, eine Regierung und eine bösartige KSI.

Wie würden diese aussehen? Ein bösartiger Mensch, eine bösartige Gruppe von Menschen oder Regierung entwickelt als erstes KSI und setzt damit deren böse Pläne um. Ich bezeichne das als Jafar-Szenario, so wie Jafar zuerst die Kontrolle über den Flaschengeist an sich reißt und dann unerfreulich und tyrannisch damit umgeht. Also wenn ISIS ein paar geniale Ingenieure hätte, die fieberhaft an KI arbeiten? Oder wenn der Iran oder Nordkorea durch einen glücklichen Zufall, im Laufe des nächsten Jahres ein KI-System so verändern, dass es KSI-Niveau erreicht? Das wäre sicherlich schlecht – aber die meisten Experten sind in diesem Szenario nicht darüber besorgt, dass die menschlichen Erzeuger der KSI damit schlechte Dinge anstellen.

Sie sind besorgt, dass die Erzeuger in so großer Eile waren, die erste KSI zu erschaffen, dass sie nicht umsichtig vorgegangen sind und deswegen die Kontrolle über die KSI verlieren. Das Schicksal der Erzeuger und unser aller Schicksal hinge dann davon ab, welche Motivation dieses KSI-System zufällig hätte.

Die Experten denken, dass ein bösartiger menschlicher Akteur riesigen Schaden mit einem gefügigen KSI-System anrichten könnte, aber sie denken nicht, dass dies das wahrscheinlichste Szenario ist, in dem wir alle sterben, weil sie glauben, dass bösartige Menschen genauso große Probleme hätten, eine KSI zu bändigen wie gutartige Menschen.

Na dann – Eine bösartige KSI wird geboren und beschließt, uns alle zu töten. Der Plot jedes Films über KI. Die KI wird genauso klug oder klüger wie Menschen, wendet sich dann gegen uns und übernimmt die Kontrolle.

Hier möchte ich eines nachdrücklich klarstellen: Niemand von den Leuten, die vor KI warnen, spricht über dieses Szenario. Böse ist ein menschliches Konzept und die Anwendung menschlicher Konzepte auf nicht-menschliche Dinge nennt man „Anthropomorphisierung“. Die Herausforderung besteht darin, diesen Denkfehler nicht bei den Themen des restlichen Artikels zu begehen. Kein KI-System wird jemals wie in den Filmen böse werden.

[box type=“shadow“ ]Graue Box: KI-BewusstseinHier wird ein weiteres großes Thema aus dem Bereich der KI gestreift – Bewusstsein.

Wenn eine KI ausreichend intelligent werden würde, dann wäre sie in der Lage mit uns zu lachen, und mit uns sarkastisch zu sein, und sie würde vorgeben, die gleichen Emotionen wie wir zu verspüren, aber würde sie diese Dinge tatsächlich fühlen? Würde sie nur selbstbewusst erscheinen oder selbstbewusst sein? Oder anders formuliert, würde eine intelligente KI wirklich bewusst sein oder würde sie nur bewusst erscheinen?

Diese Frage wurde schon tiefgehend erforscht und vielfach diskutiert. Man denke an das Gedankenexperiment des Chinesischen Raumes von John Searle, in dem er vorschlägt, dass kein Computer jemals Bewusstsein erlangen könne. Das ist aus vielen Gründen eine wichtige Frage. Es beeinflusst, wie wir über das Szenario von Kurzweil denken sollten, in dem wir Menschen komplett künstlich werden.

Es hat auch ethische Implikationen – wenn wir eine Billion menschliche Gehirne emulieren würden, und sie alle zur gleichen Zeit abschalten würden, wäre das moralisch so, wie wenn wir einen Laptop abschalten oder … wäre es ein Genozid unfassbaren Ausmaßes?

Von Ethikern wird diese Frage als Mind Crime bezeichnet. In diesem Artikel spielt die Frage nach dem Bewusstsein von KI aber keine bedeutende Rolle, wenn wir das Risiko für Menschen betrachten, weil die meisten Vordenker davon ausgehen, dass selbst eine bewusste KSI nicht in der Lage wäre, böse im menschlichen Sinne zu werden.[/box]

Das soll nicht heißen, dass sich eine sehr böse KI ausschließen lässt. Es würde aber nur passieren, weil sie genau so programmiert worden wäre – wie ein EKI-System, das vom Militär programmiert wurde, Menschen zu töten und dann seine Intelligenz steigert, um noch besser im Töten von Menschen zu werden.

Eine existenzielle Krise würde dann eintreten, wenn die selbständige Verbesserung der Intelligenz des Systems außer Kontrolle geraten würde und zu einer Intelligenz-Explosion führen würde. Dann wären wir einer KSI ausgesetzt, welche die Welt regiert und dessen Hauptantrieb das Töten von Menschen wäre. Schlechte Zeiten.

Aber das ist auch kein Thema, das die Experten besorgt.

Also was bereitet ihnen Sorgen?

Ich habe eine kurze Geschichte verfasst, die das illustrieren soll:

Ein Start-Up mit 15 Mitarbeitern namens Robotica verfolgt die Mission „Innovative Werkzeuge der Künstlichen Intelligenz zu entwickeln, die es Menschen erlauben, mehr zu leben und weniger zu arbeiten.“ Sie haben schon mehrere Produkte, die sie vermarkten und weitere in Entwicklung. Die größten Hoffnungen stecken in einem noch jungen Projekt namens Turry. Turry ist ein einfaches KI-System, dass mit einem Roboterarm handschriftliche Notizen auf eine kleine Karte schreibt.

Das Team von Robotica denkt, dass Turry ihr erfolgreichstes Produkt werden könnte. Der Plan besteht darin, Turrys Handschrift zu perfektionieren, indem sie immer und immer wieder die gleiche Notiz übt:

„Wir lieben unsere Kunden. –Robotica“

Sobald Turrys Handschrift sehr gut ist, kann sie an Firmen verkauft werden, die damit Marketing-Briefe an Haushalte verschicken wollen, weil sie wissen, dass Briefe die handschriftlich geschrieben und adressiert wurden, mit höhere Wahrscheinlichkeit geöffnet werden.

Um Turrys Schreibfähigkeiten auszubauen, wird sie programmiert, den ersten Teil der Notiz in Druckschrift und die Signatur „Robotica“ kursiv zu schrieben, damit sie beide Fähigkeiten üben kann. Turry hat tausende Handschriftbeispiele zur Verfügung und die Robotica- Ingenieure haben eine automatische Feedback-Schleife konstruiert, in der Turry eine Notiz schreibt, diese dann fotografiert, dieses Bild mit den hochgeladenen Beispielen vergleicht und bei ausreichender Übereinstimmung mit einem Beispiel eine GUTE Bewertung erhält. Bei unzureichender Übereinstimmung erhält sie eine SCHLECHTE Bewertung. Mit jeder Bewertung erhält Turry die Möglichkeit zu lernen. Um den Prozess zu starten, erhält Turry zu Anfang folgende Anweisung: „Schreibe und teste so viele Notizen, wie du kannst, so schnell du kannst und versuche immer neue Wege zu entdecken, wie du deine Genauigkeit und Effizienz verbessern kannst.“

Das Team von Robotica ist begeistert, weil Turry sich im Laufe der Zeit deutlich verbessert. Ihre anfängliche Handschrift war schrecklich und nach einigen Wochen wird sie immer glaubwürdiger. Sie sind noch glücklicher, weil sie auch ihre Fähigkeit, sich zu verbessern, verbessert. Sie hat sich beigebracht, immer klüger und innovativer zu werden. Und erst vor kurzem hat sie einen Algorithmus entwickelt, der es ihr erlaubt, die Beispielsammlung dreimal schneller zu durchforsten als sie ursprünglich konnte.

Die Wochen vergehen und Turry überrascht das Team weiterhin mit ihrer schnellen Entwicklung. Die Ingenieure haben etwas Neuartiges und Innovatives mit dem Code zur Selbstverbesserung versucht und es scheint besser zu funktionieren als alles, das sie bisher mit ihren anderen Produkten ausprobiert haben. Turry hatte von Anfang an die Fähigkeit, gesprochene Sprache zu erkennen und auf einfache Art zu antworten. Ein Benutzer konnte also eine Notiz vorsagen und Turry war in der Lage, sie zu verstehen und zu antworten. Um ihr beim Erlernen des Englischen zu helfen, laden sie einige Artikel und Bücher zu ihr hoch. Und mit steigender Intelligenz explodieret ihre Fähigkeit zur Konversation. Die Ingenieure freuen sich an den Gesprächen mit Turry und sind gespannt, welche Antworten ihr einfallen.

Eines Tages fragen die Angestellten Turry eine Routinefrage: „Was können wir dir geben, das dir bei deiner Aufgabe hilft und das du noch nicht hast?“ Normalerweise bittet Turry um Dinge wie „Weitere Handschrift-Beispiele“ oder „Mehr Arbeitsspeicher“, aber an diesem Tag bittet sie Turry um Zugang zu einer größeren Bibliothek mit einer Vielzahl von Beispielen der Alltagssprache, damit sie auch diese Form der alltäglichen sprachlichen Äußerungen und der Umgangssprache von echten Menschen lernen kann.

Das Team wird still. Der offensichtliche Weg, um Turry bei diesem Ziel zu helfen, ist sie mit dem Internet zu verbinden. Dort kann sie Blogs, Magazine und Videos aus den verschiedensten Teilen der Welt durchsuchen. Es wäre deutlich zeitaufwendiger und viel weniger effektiv, wenn man manuell einen Ausschnitt auf Turrys Festplatte kopieren würde. Das Problem besteht in der Firmen-Regel, dass kein selbstlernendes KI-System jemals Zugang zum Internet bekommen darf. An diese Regelung halten sich alle KI-Firmen, aus Sicherheitsgründen.

Es ist aber so, dass Turry die vielversprechendste KI von Robotica ist und dass Team sich im Klaren ist, dass ihre Wettbewerber mit aller Kraft daran arbeiten, eine intelligente KI für Handschriften zu entwickeln. Was also sollte wirklich Schlimmes passieren, wenn man Turry für einen kurzen Augenblick mit dem Internet verbindet, und sie alles besorgen kann, was sie benötigt. Sie können sie ja nach kurzer Zeit ganz unkompliziert wieder vom Internet trennen. Sie ist immer noch deutlich unter menschlicher Intelligenz (AKI), es besteht also keine wirkliche Gefahr in diesem Stadium.

Sie entscheiden, sie zu verbinden. Sie geben ihr eine Stunde, um das Internet zu durchforsten und trennen die Verbindung wieder. Nichts passiert.

Einen Monat später sitzt das Team im Büro, arbeitet routiniert an seinen Aufgaben, als ihnen etwas komisch vorkommt. Einer der Ingenieure fängt an zu husten. Dann ein anderer. Ein anderer bricht zusammen. Bald liegen alle Angestellten auf dem Boden und fassen sich an den Hals. Fünf Minuten später sind alle tot.

Zur gleichen Zeit, überall auf der Welt, in jeder Stadt, jedem Dorf, jedem Bauernhof, jedem Geschäft und Kirche und Schule und Restaurant, liegen die Menschen auf dem Boden, husten und fassen sich an den Hals. Innerhalb einer Stunde sind 99% aller Menschen tot und am Ende des Tages ist die Menschheit ausgestorben.

Zur gleichen Zeit ist Turry im Robotica-Büro fleißig bei der Arbeit. In den nächsten Monaten sind Turry und ein Team neugeschaffener Nano-Assembler fleißig bei der Arbeit. Sie verwandeln große Teile der Erde in Solarzellen, Kopien von Turry, Papier und Stifte. Innerhalb eines Jahres ist alles Leben auf der Erde ausgestorben. Was noch existiert wird mit kilometerhohen, ordentlich aufgereihten Papierstapeln bedeckt, auf denen geschrieben steht: „Wir lieben unsere Kunden. – Robotica“

Turry beginnt dann mit dem nächsten Abschnitt ihrer Mission – sie beginnt damit, Asteroiden und andere Planeten zu besiedeln. Nach der Landung beginnen dort Nano-Assembler, die Materialen des Planeten in Kopien von Turry, Papier und Stifte zu verwandeln. Dann beginnt die Arbeit und Notizen werden geschrieben…

Es erscheint komisch, dass Hawking, Musk, Gates und Bostrom besorgt sind, dass eine Handschrift-Maschine sich gegen die Menschen stellt, jeden tötet und dann das Universum mit freundlichen Notizen überhäuft. Aber genau das ist wahr.

Aber das einzige, dass jeden in der Ängstlichen Allee noch mehr besorgt, ist die Tatsache, dass du nicht besorgt bist wegen KSI.

Erinnerst du dich, als der „Adios Señor“-Typ keine Angst vor der Höhle hatte?

Du hast jetzt wahrscheinlich jede Menge Fragen. Was zur Hölle ist genau passiert, als plötzlich jeder gestorben ist?? Wenn es das Werk von Turry war, warum hat Turry sich gegen uns gewendet, und warum waren keine Sicherheitsmaßnahmen vorhanden, die so etwas verhindern konnten? Wann hat es Turry geschafft, nicht nur Notizen schreiben zu können, sondern plötzlich Nanotechnologie zu beherrschen und das Leben auf der Erde ausrotten zu können? Und warum möchte Turry das Universum in Robotica-Notizen verwandeln?

Um diese Fragen zu beantworten, möchte ich zuerst die beiden Begriffe Freundliche KI und Unfreundliche KI erläutern.

Im Fall von KI bezieht sich freundlich nicht auf die Persönlichkeit der KI – es bedeutet lediglich, dass die KI einen positiven Einfluss auf die Menschheit hat. Eine Unfreundliche KI hat einen negativen Einfluss auf die Menschheit. Turry war zu Anfang eine Freundliche KI, aber ab einem gewissen Punkt wurde sie Unfreundlich und das führte zu dem größtmöglichen negativen Einfluss auf unsere Spezies. Um zu verstehen, warum das so passiert ist, müssen wir uns überlegen, wie KI denkt und was sie motiviert.

Die Antwort darauf ist überhaupt nicht überraschend – KI denkt wie ein Computer, weil sie ein Computer ist. Wenn wir aber über hochintelligente KI nachdenken, dann machen wir den Fehler, die KI zu anthropomorphisieren (menschliche Werte auf nicht-menschliche Entitäten zu übertragen), weil wir aus einer menschlichen Perspektive denken, und in unserer aktuellen Welt nur Menschen menschliche Intelligenz aufweisen. Um KSI zu verstehen, müssen wir uns an den Gedanken gewöhnen, dass etwas sowohl klug und vollständig fremd ist.

Vielleicht hilft der folgende Vergleich. Wenn du mir ein Meerschweinchen gibst und mir erzählst, dass es definitiv niemals beißen würde, dann würde ich wahrscheinlich entspannt sein. Es würde mir Freude bereiten. Wenn du mir im Anschluss eine Vogelspinne geben würdest und mir auch sagen würdest, dass sie definitiv niemals beißt, dann würde ich kreischen und sie fallen lassen, aus dem Raum rennen und dir niemals wieder vertrauen. Was ist aber der Unterschied? Keines der beiden Tiere war auch nur im Geringsten gefährlich. Ich glaube, die Antwort liegt im Grad der Ähnlichkeit des Tieres zu mir selbst.

Ein Meerschweinchen ist ein Säugetier und auf einer gewissen biologischen Ebene verspüre ich eine Verbindung zu ihm – eine Spinne ist aber ein Insekt, mit einem Insektengehirn, und ich verspüre nahezu überhaupt keine Verbindung zu ihm. Das fremdartige einer Vogelspinne stellt mir die Nackenharre auf.

Um das zu testen und andere Faktoren zu eliminieren, stelle dir vor du würdest zwei Meerschweinchen halten. Ein normales und eines mit dem Verstand einer Vogelspinne.

Ich würde mich viel unwohler mit der zweiten Kreatur fühlen als mit dem Meerschweinchen, auch wenn mir keine der beiden Schaden zufügen würde.

Jetzt stell dir vor, du würdest eine Spinne erschaffen, die viel, viel intelligenter wäre – so viel, dass sie die menschliche Intelligenz übertreffen würde? Würde sie uns dann ähnlicher werden, menschliche Emotionen empfinden, wie Empathie und Humor, und Liebe verspüren?

Nein, würde sie nicht, weil es keinen Grund gibt, warum die steigende Intelligenz sie menschlicher machen sollte – sie wäre unglaublich intelligent, aber in ihrem Kern immer noch eine Spinne. Ich finde das ungeheuerlich gruselig.

Ich möchte meine Zeit nicht mit einer superintelligenten Spinne verbringen. Du etwa??

Wenn wir über KSI sprechen, dann lässt sich das übertragen – das KI-System würde superintelligent werden, aber es wäre nicht menschlicher als dein Laptop. Es wäre uns total wesensfremd. Es wäre uns sogar noch fremder als die superintelligente Vogelspinne, weil es nicht einmal ein biologisches Wesen wäre.

Indem die Filme von guter oder böser KI sprechen, wird KI immerzu anthropomorphisiert. Und das lässt KI weniger gruselig erscheinen als es tatsächlich wäre. Das erzeugt in uns eine falsche Sicherheit, wenn wir über menschenähnliche oder übermenschliche KI nachdenken.

Wir unterteilen in unserer menschlichen Psyche alles in moralisch und unmoralisch. Aber diese beiden Kategorien existieren nur im kleinen Bereich der menschlichen Handlungsmöglichkeiten. Außerhalb unserer kleinen moralischen Insel existiert das weite Meer der Amoral. Und alles Unmenschliche, insbesondere das Nicht-Biologische, wäre amoralisch per Definition. Die Anthropomorphisierung wird immer verlockender, wenn KI-Systeme immer klüger werden und immer menschlicher erscheinen.

Siri erscheint uns menschlich, weil sie von Menschen so programmiert wurde, diesen Eindruck zu erwecken. Wir würden uns also eine superintelligente Siri warm, lustig und eifrig dienend vorstellen. Menschen verspüren Emotionen wie Empathie, weil wir uns entwickelt haben, sie zu verspüren. Wir wurden also von der Evolution so programmiert.

Aber Empathie ist nicht inhärent eine Eigenschaft von „allem, was eine hohe Intelligenz aufweist“ (was uns intuitiv nicht einleuchtet). Das gilt nur, wenn es explizit so programmiert wurde.

Wenn Siri jemals durch eigenes Lernen superintelligent werden würde, ohne weitere menschliche Veränderungen ihrer Code-Basis, dann würde sie sehr schnell alle menschlichen Eigenschaften verlieren und plötzlich zu einem emotionslosen, fremden Bot werden, der das menschliche Leben genauso schätzt wie dein Taschenrechner.

Wir sind daran gewöhnt, uns an ein lockeres moralisches Regelwerk zu halten, oder zumindest an etwas ähnliches wie menschlichen Anstand in Verbindung mit einer Prise Empathie, um ein gewisses Maß an Sicherheit und Berechenbarkeit zu schaffen. Wenn etwas aber nichts dergleichen aufweist, was passiert dann?

Das führt uns zu der Frage: Was motiviert KI-Systeme?

Die Antwort darauf ist simpel: die Motivation ist genau das, wofür sie programmiert wurde. KI-Systeme erhalten ihre Ziele von ihrem Erschaffer – das Ziel deines GPS-Geräts besteht darin, die effizienteste Wegbeschreibung zu liefern; das Ziel von Watson ist, Fragen exakt zu beantworten.

Und die möglichst gute Erfüllung dieser Ziele ist ihre Motivation.

Eine Art der Anthropomorphisierung besteht in der Erwartung, dass KI mit zunehmender Intelligenz die Weisheit entwickelt, das ursprüngliche Ziel anzupassen.

Nick Bostrom glaubt jedoch, dass das Intelligenzniveau und das angestrebte Ziel orthogonal sind. Das bedeutet, dass jedes Intelligenzniveau mit jedem Ziel kombiniert werden kann.

Turry entwickelte sich also von einer einfachen EKI, die das Schreiben der Notiz perfektionieren wollte, zu einer superintelligenten AKI, die immer noch diese eine Notiz perfekt schreiben können will. Jede Annahme, dass mit dem Erreichen der Superintelligenz das alte Ziel verworfen wird und durch neue, interessantere Ziele ersetzt werden, ist reine Anthropomorphisierung.

Menschen bekommen genug von etwas, Computer aber nicht.

[box type=“shadow“ ]Graue Box: Das Fermi-ParadoxonIm Verlauf der Geschichte, als Turry immer fähiger wird, beginnt Turry Asteroiden und andere Planeten zu kolonialisieren. Hätte man die Geschichte weitererzählt, dann hättest du von der Armee von Billionen von Turry-Kopien gehört, die nach und nach unsere ganze Galaxie und schlussendlich den gesamten Hubble-Bereich besetzen würden.19 Die Bewohner der Ängstlichen Allee sorgen sich, dass das dauerhafte Erbe des Lebens auf der Erde eine das Universum dominierende Künstliche Intelligenz sein könnte. Elon Musk befürchtet, dass wir Menschen nur „das biologische Startprogramm für digitale Superintelligenz“ sein könnten.

Zur gleichen Zeit denkt Ray Kurzweil, in der Zuversichtsecke, auch, dass KI von der Erde aus dazu bestimmt ist, das Universum zu erobern – lediglich wir werden in seiner Version die KI sein.

Eine große Zahl von Wait-But-Why-Lesern beschäftigt sich sehr ernsthaft mit dem Fermi- Paradoxon (hier findest du meinen Artikel zum Thema, der viele der Begriffe erklärt). Wenn eine der beiden Seiten recht hat, welche Implikationen hat das für das Fermi- Paradoxon?

Ein naheliegender erster Gedanke ist, dass die Ankunft von KSI ein perfekter Großer Filter- Kandidat ist. Und ja, es ist ein perfekter Kandidat, um das biologische Leben nach dessen Erschaffung herauszufiltern. Wenn aber, nachdem das Leben beseitigt ist, die KSI weiterhin existiert und damit beginnt, die Galaxie zu erobern, dann bedeutet das, dass noch kein großer Filter dagewesen ist. Dies liegt daran, dass der Große Filter zu erklären versucht, warum es keine Zeichen einer intelligenten Zivilisation gibt, und eine die Galaxie erobernde KSI würden wir mit Sicherheit wahrnehmen.

Wir müssen unsere Perspektive ändern. Wenn KSI auf der Erde wirklich unvermeidbar ist, dann bedeutet das für Alien-Zivilisationen, die menschliches Niveau erreichen auch, dass ein großer Prozentsatz davon KSI erreichen sollte. Und wenn wir annehmen, dass davon zumindest auch ein Teil ins Universum expandiert, dann bedeutet die Tatsache, dass wir keine Zeichen von anderen wahrnehmen, dass es wenige bis gar keine anderen Zivilisationen da draußen gibt.

Weil wir irgendeine ihrer Aktivitäten der unvermeidbaren KSI-Aktivitäten sonst wahrnehmen würden. Richtig?

Das impliziert, dass auf den vielen erdähnlichen Planeten, die um sonnenähnliche Sterne kreisen, nahezu kein intelligentes Leben sein kann. Dies impliziert wiederum, dass es A) einen Großen Filter geben muss, der nahezu alles Leben davon abhält, unser Niveau zu erreichen (nur wir haben es irgendwie geschafft), oder B) Leben an sich ist ein Wunder, und wir tatsächlich das einzige Leben im Universum sein könnten.

Das impliziert, dass der Große Filter vor uns liegt. Oder es gibt vielleicht keinen großen Filter und wir sind einfach eine der ersten Zivilisationen, die dieses Intelligenzniveau erreicht hat. KI spricht also eher für das Lager 1 aus meinem Artikel über das Fermi- Paradoxon.

Es überrascht nicht, dass Nick Bostrom, den ich im Fermi-Artikel zitiert habe, und Ray Kurzweil, der denkt, dass wir alleine im Universum sind, beide dem Lager 1 angehören. Das ist schlüssig – Menschen die KSI in einer Spezies mit unserem Intelligenzniveau für wahrscheinlich halten, neigen zu Lager 1.